一、初识

接口文档:https://easydoc.net/doc/75716633/ZUqEdvA4/E97bmStq

最后要将同类的笔记整理到一起

【值得学习】

简介

springboot v2.3.7.RELEASE

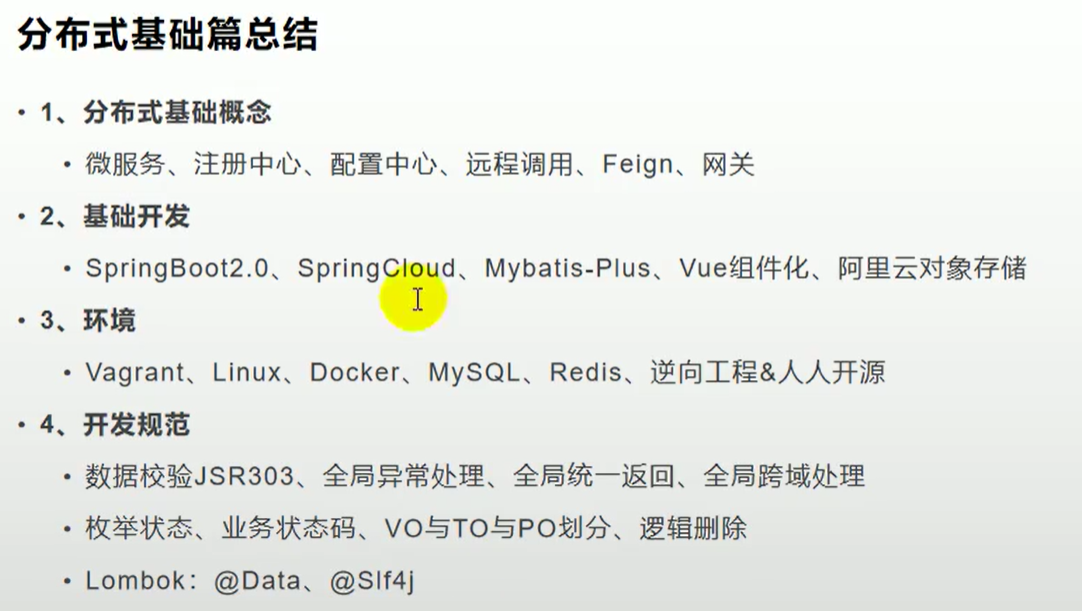

高级篇

springcloud组件:nacos注册中心、配置中心、sentinel、seata、oss、feign、gateway、sleuth +zipkin

webflux、 shardingsphere【值得学习】

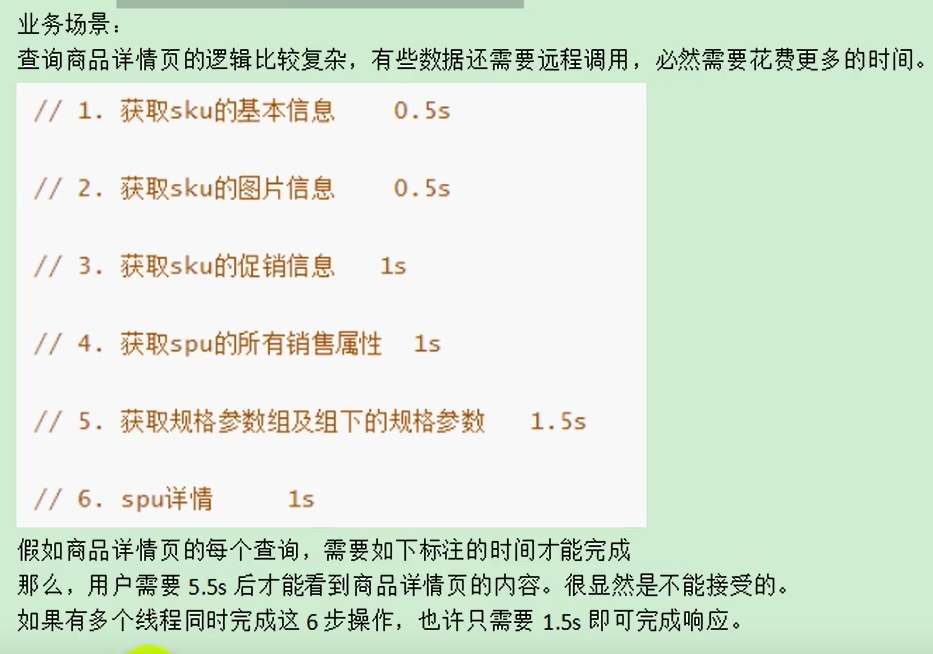

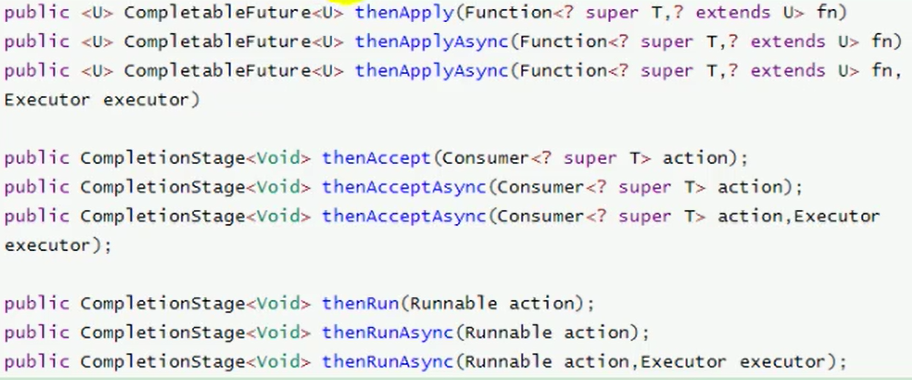

接口幂等性、本地事务,分布式事务、jmeter等性能压力测试工具、ElasticSearch、异步线程池、单点登录、社交登陆、商城业务(购物车、订单、秒杀,商品详情:redis、springcache,数据不一致问题,击穿穿透)

rabbitmq(关单死信队列、最终一致、消峰解耦),支付宝沙箱、定时任务

准备

项目接口文档:https://easydoc.xyz/doc/75716633/ZUqEdvA4/hKJTcbfd

openfeign

虚拟机

使用vagrant和virtualBox可以快速创建虚拟机

$ vagrant init centos/7执行完上面的命令后,会在用户的家目录下生成Vagrantfile文件。

$ vagrant up下载镜像过程比较漫长,也可以采用先用下载工具下载到本地后,然后使用“ vagrant box add ”添加,再“vagrant up”即可

#将下载的镜像添加到virtualBox中

$ vagrant box add centos/7 E:\迅雷下载\CentOS-7-x86_64-Vagrant-1905_01.VirtualBox.box

#启动

$ vagrant up缺点:端口映射(如Docker)

vagrant ssh或者vagrantFile添加网卡信息

C:\Users\Administrator>ipconfig

Windows IP 配置

以太网适配器 VirtualBox Host-Only Network:

连接特定的 DNS 后缀 . . . . . . . :

本地链接 IPv6 地址. . . . . . . . : fe80::a00c:1ffa:a39a:c8c2%16

IPv4 地址 . . . . . . . . . . . . : 192.168.56.1

子网掩码 . . . . . . . . . . . . : 255.255.255.0

默认网关. . . . . . . . . . . . . :配置网络信息,打开”Vagrantfile”文件:

config.vm.network "private_network", ip: "192.168.56.10"修改完成后,重启启动vagrant

vagrant reload检查宿主机和virtualBox之间的通信是否正常

[vagrant@localhost ~]$ ping 192.168.43.43 PING 192.168.43.43 (192.168.43.43) 56(84) bytes of data.

64 bytes from 192.168.43.43: icmp_seq=1 ttl=127 time=0.533 ms

64 bytes from 192.168.43.43: icmp_seq=2 ttl=127 time=0.659 ms

--- 192.168.43.43 ping statistics ---

2 packets transmitted, 2 received, 0% packet loss, time 999ms

rtt min/avg/max/mdev = 0.533/0.596/0.659/0.063 ms

[vagrant@localhost ~]$

[vagrant@localhost ~]$

[vagrant@localhost ~]$ ping www.baidu.com

PING www.a.shifen.com (112.80.248.76) 56(84) bytes of data.

64 bytes from 112.80.248.76 (112.80.248.76): icmp_seq=1 ttl=53 time=56.1 ms

64 bytes from 112.80.248.76 (112.80.248.76): icmp_seq=2 ttl=53 time=58.5 ms

64 bytes from 112.80.248.76 (112.80.248.76): icmp_seq=3 ttl=53 time=53.4 ms

开启远程登陆,修改“/etc/ssh/sshd_config”

PermitRootLogin yes

PasswordAuthentication yes然后重启SSHD

systemctl restart sshd

docker

systemctl enable docker # 自启动启动系统即运行docker容器

docker update mysql --restart=always

docker update redis --restart=alwaysmysql

docker run -p 3306:3306 --name mysql \

-v /mydata/mysql/master/log:/var/log/mysql \

-v /mydata/mysql/master/data:/var/lib/mysql \

-v /mydata/mysql/master/conf:/etc/mysql \

-e MYSQL_ROOT_PASSWORD=root \

-d mysql:5.7# pwd

/mydata/mysql/conf

# cat my.cnf

[client]

default-character-set=utf8

[mysql]

default-character-set=utf8

[mysqld]

init_connect='SET collation_connection = utf8_unicode_ci'

init_connect='SET NAMES utf8'

character-set-server=utf8

collation-server=utf8_unicode_ci

skip-character-set-client-handshake

skip-name-resolve(1 )打开cmd,登录到mysql

mysql -u root -p

(2) 输入授权语句:

GRANT ALL PRIVILEGES ON *.* TO 'root'@'%'IDENTIFIED BY 'root' WITH GRANT OPTION;

# 赋予所用权限给root账户从任何iP以mypassword为密码登录

GRANT ALL PRIVILEGES ON *.* TO 'myuser'@'192.168.1.3'IDENTIFIED BY '123' WITH GRANT OPTION;

# 赋予所用权限给myuser账户从任何192.168.1.3以123为密码登录

(3) FLUSH PRIVILEGES;redis

docker pull redis启动

mkdir -p /mydata/redis/conf

touch /mydata/redis/conf/redis.conf

echo "appendonly yes" >> /mydata/redis/conf/redis.conf # 持久化

docker run -p 6379:6379 --name redis -v /mydata/redis/data:/data \

-v /mydata/redis/conf/redis.conf:/etc/redis/redis.conf \

-d redis redis-server /etc/redis/redis.conf连接到docker的redis

docker exec -it redis redis-cli

set key1 v1

get key1设置redis容器在docker启动的时候启动

docker update redis --restart=always人人开源

值得研究!

代码生成器

- 修改application.yaml与generator.properties,配置数据库相关信息

- 运行查看界面下载

前端

值得研究:

- 添加和修改抽离出组件

ui库比较低,修改src/element-ui/index.js

后端

值得研究:

- 各种工具类,如:分页等

mp

将项目中的各种依赖包放入common,需要配置mp分页插件,否则分页有误

@Configuration

@EnableTransactionManagement // 开启事务

@MapperScan("com.ming.gulimall.product.dao")

public class MybatisConfig {

// 分页插件

@Bean

public PaginationInterceptor paginationInterceptor() {

// .setOverflow(false),超过最后一页,true第一页,false继续请求

// .setLimit(500),最大单页限制数量,默认500条,-1不

return new PaginationInterceptor();

}

}项目初始化

powerdesign

创建

初始化网址:https://start.aliyun.com

操作:

- 父maven,pom并modules

- 子module,通过common聚合

视频:

empty父项目

子springboot项目(web、openfeign)

父项目添加pom,并添加到maven

<packaging>pom</packaging>

<modules>

<module>gulimall-coupon</module>

<module>gulimall-member</module>

<module>gulimall-order</module>

<module>gulimall-product</module>

<module>gulimall-ware</module>

</modules>gitignore

下面是一些.gitignore文件忽略的匹配规则:

*.a # 忽略所有 .a 结尾的文件

!lib.a # 但 lib.a 除外

/TODO # 仅仅忽略项目根目录下的 TODO 文件,不包括 subdir/TODO

build/ # 忽略 build/ 目录下的所有文件

doc/*.txt # 会忽略 doc/notes.txt 但不包括 doc/server/arch.txt

**/.mvn # 忽略所有下的.mvn

**/target/ # target下的所有东西

.idea

下载gitee插件

maven

下载太慢

setting.xml

<mirror>

<id>nexus-aliyun</id>

<mirrorOf>*</mirrorOf>

<name>Nexus aliyun</name>

<url>http://maven.aliyun.com/nexus/content/groups/public</url>

</mirror>java版本

D:\Environment\apache-maven-3.6.1\conf\setting.xml

<profile>

<id>development</id>

<activation>

<jdk>1.8</jdk>

<activeByDefault>true</activeByDefault>

</activation>

<properties>

<maven.compiler.source>1.8</maven.compiler.source>

<maven.compiler.target>1.8</maven.compiler.target>

<maven.compiler.compilerVersion>1.8</maven.compiler.compilerVersion>

</properties>

</profile>pom

maven中三种classpath

编译,测试,运行

- compile:默认范围,编译测试运行都有效

- provided:在编译和测试时有效

- runtime:在测试和运行时有效

- test:只在测试时有效

- system:在编译和测试时有效,与本机系统关联,可移植性差

<dependency>

<groupId>javax.servlet</groupId>

<artifactId>servlet-api</artifactId>

<version>2.5</version>

<scope>provided</scope>

</dependency>Error

Diamond types are not supported at this language level

版本老是不一致

正确:https://blog.csdn.net/isea533/article/details/48575983

pom添加

<build>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-compiler-plugin</artifactId>

<version>2.3.2</version>

<configuration>

<source>1.8</source>

<target>1.8</target>

</configuration>

</plugin>

</plugins>

</build>https://blog.csdn.net/liu16659/article/details/80230164 修改idea配置

https://blog.csdn.net/weixin_36210698/article/details/72085710 修改pom

java.lang.IllegalStateException: Unable to find a @SpringBootConfiguration, you need to use @ContextConfiguration or @SpringBootTest(classes=…) with your test

测试类与启动类不再同一包下

字符集UTF-8

https://blog.csdn.net/m0_38132361/article/details/80628203

Too many connections

java.sql.SQLNonTransientConnectionException: Data source rejected establishment of connection, message from server: “Too many connections”

一直运行不起来

将依赖放入一个pom,规定springboot相关版本?

<parent>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-parent</artifactId>

<version>2.1.7.RELEASE</version>

<relativePath/> <!-- lookup parent from repository -->

</parent>数据库连接池

idleTimeout is close to or more than maxLifetime

当连接池的参数idleTimeout或maxLifetime大于数据库的interactive_timeout或wait_timeout时,连接池里的连接没过期,但数据库那边已经过期了,就会出现上面的错误。

spring:

datasource:

hikari:

connection-timeout: 10000

validation-timeout: 3000

idle-timeout: 60000

login-timeout: 5

max-lifetime: 60000

maximum-pool-size: 10

minimum-idle: 3

read-only: falseFeign连接超时

# feign调用超时时间配置

feign:

client:

config:

default:

connectTimeout: 10000

readTimeout: 600000整合

数据库

- 导入依赖

- 配置

- 数据源

- 数据库驱动

- 数据源配置信息

- @Mapperscan,dao

- 映射文件路径,mapper

- 数据源

1)、导入依赖

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>8.0.26</version>

</dependency>

<dependency>

<groupId>com.baomidou</groupId>

<artifactId>mybatis-plus-boot-starter</artifactId>

<version>3.2.0</version>

</dependency>2)、配置

1、配置数据源;

1)、导入数据库的驱动。https://dev.mysql.com/doc/connector-j/8.0/en/connector-j-versions.html

2)、在application.yml配置数据源相关信息

spring:

datasource:

username: root

password: root

url: jdbc:mysql://#:3306/gulimall_pms

driver-class-name: com.mysql.cj.jdbc.Driver2、配置MyBatis-Plus;

1)、使用@MapperScan,如果使用了@Mapper就不需要

2)、告诉MyBatis-Plus,sql映射文件位置

mybatis-plus:

mapper-locations: classpath:/mapper/**/*.xml

global-config:

db-config:

#主键自增

id-type: auto测试

注意些

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

</dependency>@RunWith(SpringRunner.class)

@SpringBootTest(classes = StudyApplication.class) // 可以不写()后面的

public class Test {

@Autowired

private UserService userService;

@org.junit.Test

public void test() {

System.out.println(userService.loginOrRegister(new UserLoginVo("1", "2")));

}

}二、分布式

nacos

阿里巴巴cloud:https://github.com/alibaba/spring-cloud-alibaba/blob/master/README-zh.md

添加微服务

- 添加pom,服务发现依赖

- 配置nacos.discovery.server-addr,application.name,server.port

- 添加@EnableDiscoveryClient

- 网关添加路由

docker

docker pull nacos/nacos-server:1.4.1

docker run --env MODE=standalone --name nacos -d -p 8848:8848 nacos/nacos-server:1.4.1

docker run -d \

-e MODE=standalone \

-e SPRING_DATASOURCE_PLATFORM=mysql \

-e MYSQL_SERVICE_HOST=xxx \

-e MYSQL_SERVICE_PORT=3306 \

-e MYSQL_SERVICE_USER=root \

-e MYSQL_SERVICE_PASSWORD=xxx \

-e MYSQL_SERVICE_DB_NAME=nacos \

-p 8848:8848 \

--restart=always \

--name mynacos \

nacos/nacos-server注册发现

1.依赖

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-nacos-discovery</artifactId>

<version>2.1.0.RELEASE</version>

</dependency>2.配置(nacos位置和应用名称)

spring.application.name=gulimall-coupon

spring.cloud.nacos.discovery.server-addr=127.0.0.1:8848

# or

spring:

cloud:

nacos:

discovery:

server-addr: 127.0.0.1:8848

application:

name: gulimall-coupon可以存入bootstrap.properties

spring.application.name=gulimall-coupon

spring.cloud.nacos.config.server-addr=127.0.0.1:88483.启动

@EnableDiscoveryClient

配置中心

应用

优先使用配置中心的配置

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-nacos-config</artifactId>

<version>2.1.0.RELEASE</version>

</dependency>bootstrap.properties,会先于application.properties

spring.application.name=gulimall-coupon

spring.cloud.nacos.config.server-addr=127.0.0.1:8848nacos配置中心添加数据集(Data Id)gulimall-coupon.properties,应用名.properties

需要使用的地方类上添加@RefreshScope,使用@Value动态获取配置

error

就是不改变!!!!

config版本?

命名空间

#命名空间id

spring.cloud.nacos.config.namespace=6399421b-1c23-45bb-817d-79b9928348db配置分组

group: dev

spring.cloud.nacos.config.group=dev配置拆分

spring.cloud.nacos.config.ext-config[0].data-id=redis.properties

# 开启动态刷新配置,否则配置文件修改,工程无法感知

spring.cloud.nacos.config.ext-config[0].refresh=true

spring.cloud.nacos.config.ext-config[1].data-id=jdbc.properties

spring.cloud.nacos.config.ext-config[1].refresh=trueopenfeign

- 创建时就引入了依赖

- 要调用的服务创建接口

依赖

<properties>

<spring-cloud.version>Hoxton.SR9</spring-cloud.version>

</properties>

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-openfeign</artifactId>

</dependency>

<dependencyManagement>

<dependencies>

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-config-dependencies</artifactId>

<version>2.1.0.RELEASE</version>

<type>pom</type>

<scope>import</scope>

</dependency>

</dependencies>

</dependencyManagement># feign调用超时时间配置

feign:

client:

config:

default:

connectTimeout: 10000

readTimeout: 600000@FeignClient("gulimall-coupon")

public interface CouponFeignService {

@RequestMapping("/coupon/coupon/member/list")

public R memberCoupons();

}源码:

先判断是不是toString hashCode这些方法,如果不是就调用原方法,

Feign将参数转为json,封装到template中,里面有url,编码模式等,负载均衡执行请求并解码

异常则重试器会重复(有default实现本接口,重复一定次数),也可以用neverTry,直接抛异常,重试器默认关闭

头丢失问题

默认不携带头信息,添加requestInterceptor,通过RequestContextHolder获取线程request属性

@Configuration

public class GuliFeignConfig {

@Bean

public RequestInterceptor requestInterceptor() {

return new RequestInterceptor() {

@Override

public void apply(RequestTemplate template) {

//1. 使用RequestContextHolder拿到老请求的请求数据

ServletRequestAttributes requestAttributes = (ServletRequestAttributes) RequestContextHolder.getRequestAttributes();

if (requestAttributes != null) {

HttpServletRequest request = requestAttributes.getRequest();

if (request != null) {

//2. 将老请求得到cookie信息放到feign请求上

String cookie = request.getHeader("Cookie");

template.header("Cookie", cookie);

}

}

}

};

}

}

线程下执行还是丢失,已经不是原来的线程,无法获取到threadLocal中的requestAttributes

RequestAttributes requestAttributes = RequestContextHolder.getRequestAttributes();

CompletableFuture.supplyAsync(() -> {

RequestContextHolder.setRequestAttributes(requestAttributes);

List<OrderItemVo> checkedItems = cartFeignService.getCheckedItems();

return checkedItems;

}, executor)GateWay

官网:https://docs.spring.io/spring-cloud-gateway/docs/2.2.9.RELEASE/reference/html/

还要学习:https://blog.csdn.net/qq_38380025/article/details/102968559

路由转发、快速转发到后台服务上

- 统一的熔断、限流、认证、日志监控

- 与服务注册中心完美整合,Eureka、Consul、Nacos

springCloud GateWay特征

- 动态路由,匹配任何请求属性

- SpringCloud服务发现功能

- 路由指定Predicate(断言)、Filter(过滤器)

- 集成Hystrix断路器

- 请求限流功能

- 路径重写

过程:

接受请求,GateWay Handler Mapping找到匹配的路由,发送到Web Handler,通过指定的过滤器链将请求发送到实际的服务执行业务逻辑,过滤器会代理请求之前和请求之后业务逻辑

pre:参数校验、权限校验、流量监控、日志输出、协议转换

post:响应内容、响应头修改、日志输出、流量监控

依赖

<properties>

<java.version>1.8</java.version>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

<project.reporting.outputEncoding>UTF-8</project.reporting.outputEncoding>

<spring-boot.version>2.3.7.RELEASE</spring-boot.version>

<spring-cloud.version>Hoxton.SR9</spring-cloud.version>

</properties>

<dependencies>

<dependency>

<groupId>com.ming.gulimall</groupId>

<artifactId>gulimall-common</artifactId>

<version>0.0.1-SNAPSHOT</version>

</dependency>

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-gateway</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<scope>test</scope>

<exclusions>

<exclusion>

<groupId>org.junit.vintage</groupId>

<artifactId>junit-vintage-engine</artifactId>

</exclusion>

</exclusions>

</dependency>

</dependencies>

<dependencyManagement>

<dependencies>

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-dependencies</artifactId>

<version>${spring-cloud.version}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-dependencies</artifactId>

<version>${spring-boot.version}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

</dependencies>

</dependencyManagement>Yaml配置

spring:

cloud:

gateway:

routes:

- id: test_route

uri: https://www.baidu.com

predicates:

- Query=url,baidu

# 1. 管理后台,通过路径转发

- id: admin_route

# 负载均衡

uri: lb://renren-fast

# 匹配路径

predicates:

- Path=/api/**

filters:

# 替换路径

- RewritePath=/api/(?<segment>.*),/renren-fast/$\{segment}

# 2. 首页,通过域名转发

- id: index

uri: lb://index

# 匹配路径

predicates:

- Host=**.mingyuefusu.cn

访问

predicate

Host

predicates:

- Host=**.somehost.org,**.anotherhost.orgHttp Method

predicates:

- Method=GETPath

# /foo/.* 或/bar/.*

predicates:

- Path=/foo/{segment},/bar/{segment}获取segment

PathMatchInfo variables = exchange.getAttribute( URI_TEMPLATE_VARIABLES_ATTRIBUTE );

Map<String, String> uriVariables = variables.getUriVariables();

String segment = uriVariables.get("segment");Query

# 查询参数foo的内容ba.正则规则

predicates:

- Query=foo, ba.RemoteAddr

predicates:

- RemoteAddr=192.168.1.1/24时间

# 时间之后匹配

predicates:

- After=2018-12-25T14:33:47.789+08:00

# 时间之前匹配

predicates:

- Before=2018-12-25T14:33:47.789+08:00

# 时间之间

- Between=2018-12-25T14:33:47.789+08:00, 2018-12-26T14:33:47.789+08:00cookie

# 存在名为cookiename,内容匹配value的

predicates:

- Cookie=cookiename, cookievalueHeader

# 头部存在X-Request-Id,内容为数字的header的请求

predicates:

- Header=X-Request-Id, \d+Filter

rewritePath

# 路径是/foo/bar,改为/bar

# YAML 的格式中使用$\来代替$。

filters:

- RewritePath=/foo/(?<segment>.*), /$\{segment}header

filters:

- AddRequestHeader=X-Request-Foo, Barparameter

filters:

- AddRequestParameter=foo, barresponseHeader

filters:

- AddResponseHeader=X-Response-Foo, Bar熔断器

引入spring-cloud-starter-netflix-hystrix依赖,并提供HystrixCommand的名字,即可生效Hystrix GatewayFilter

filters:

- Hystrix=myCommandNamefallbackUri,来支持路由熔断后的降级处理,降级后,请求会跳到fallbackUri配置的路径

filters:

- name: Hystrix

args:

name: fallbackcmd

fallbackUri: forward:/incaseoffailureusethis降级跳到外部的服务

spring:

cloud:

gateway:

routes:

- id: ingredients

uri: lb://ingredients

predicates:

- Path=//ingredients/**

filters:

- name: Hystrix

args:

name: fetchIngredients

fallbackUri: forward:/fallback

- id: ingredients-fallback

uri: http://localhost:9994

predicates:

- Path=/fallback跨域问题

原本

@Configuration

public class CorsConfig implements WebMvcConfigurer {

// @Override

// public void addCorsMappings(CorsRegistry registry) {

// registry.addMapping("/**")

// .allowedOrigins("*")

// .allowCredentials(true)

// .allowedMethods("GET", "POST", "PUT", "DELETE", "OPTIONS")

// .maxAge(3600);

// }

}网关中统一解决

注意与第一个不要重复,否则会重复响应头,如果失败,查看是否启动了两个服务?

import org.springframework.web.cors.reactive.CorsWebFilter;

import org.springframework.web.cors.reactive.UrlBasedCorsConfigurationSource;

@Configuration

public class GulimallCorsConfiguration {

@Bean

public CorsWebFilter corsWebFilter() {

UrlBasedCorsConfigurationSource source = new UrlBasedCorsConfigurationSource();

CorsConfiguration corsConfiguration = new CorsConfiguration();

// 1、配置跨域

corsConfiguration.addAllowedHeader("*");

corsConfiguration.addAllowedMethod("*");

corsConfiguration.addAllowedOrigin("*");

corsConfiguration.setAllowCredentials(true);

source.registerCorsConfiguration("/**", corsConfiguration);

return new CorsWebFilter(source);

}

}Boot

JSR303

依赖

2.3之后默认移除了

<dependency>

<groupId>org.hibernate.validator</groupId>

<artifactId>hibernate-validator</artifactId>

<version>6.0.17.Final</version>

<scope>compile</scope>

</dependency>普通使用

实体类顺序添加@NotBlank等注解,提示默认为\org\hibernate\validator\ValidationMessages_zh_CN.properties中的提示语

@NotBlank(message = "")

@Pattern(regexp = "^[a-zA-Z]$", message = "检索首字母必须是一个字母")

@NotEmpty //不能为null或""

@NotBlank //不能为null,并且至少包含一个非空白字符

@Data

@TableName("pms_brand")

public class BrandEntity implements Serializable {

private static final long serialVersionUID = 1L;

/**

* 品牌id

*/

@TableId

@NotNull(

message = "修改需要指定id",

groups = { UpdateGroup.class }

)

@Null(

message = "添加不能指定id",

groups = { AddGroup.class }

)

private Long brandId;

/**

* 品牌名

*/

@NotBlank(message = "品牌名必须提交", groups = { AddGroup.class})

private String name;

/**

* 品牌logo地址

*/

@NotBlank(groups = {AddGroup.class})

@URL(message = "logo需要是合理的url地址", groups = {AddGroup.class, UpdateGroup.class}) // 修改带上了就要符合

private String logo;

/**

* 介绍

*/

private String descript;

/**

* 显示状态[0-不显示;1-显示]

*/

@NotNull( groups = {AddGroup.class})

@ListValue(vals={0, 1}, groups = {AddGroup.class, UpdateGroup.class})

private Integer showStatus;

/**

* 检索首字母

*/

@NotEmpty( groups = {AddGroup.class})

@Pattern(regexp = "^[a-zA-Z]$", message = "检索首字母必须是一个字母", groups = {AddGroup.class, UpdateGroup.class})

private String firstLetter;

/**

* 排序

*/

@NotNull( groups = {AddGroup.class})

@Min(value=0, message = "排序必须大于零", groups = {AddGroup.class, UpdateGroup.class})

private Integer sort;

}接收数据前@Valid,或者@Validated进行指定分组

分组校验

使用分组校验时,没加分组的字段将不进行校验

public R update( @Validated({UpdateGroup.class} ) @RequestBody BrandEntity brand){}接收异常

@RequestMapping("/update")

// @RequiresPermissions("product:brand:update")

public R update(@Valid @RequestBody BrandEntity brand, BindingResult result){

if(result.hasErrors()) {

Map<String, String> map = new HashMap<>();

result.getFieldErrors().forEach((item) -> {

map.put(

item.getField(),

item.getDefaultMessage()

);

});

return R.error(400, "数据不合法").put("data", map);

}

brandService.updateById(brand);

return R.ok();

}规则汇总

javax.validation.constraints.AssertFalse.message = 只能为false

javax.validation.constraints.AssertTrue.message = 只能为true

javax.validation.constraints.DecimalMax.message = 必须小于或等于{value}

javax.validation.constraints.DecimalMin.message = 必须大于或等于{value}

javax.validation.constraints.Digits.message = 数字的值超出了允许范围(只允许在{integer}位整数和{fraction}位小数范围内)

javax.validation.constraints.Email.message = 不是一个合法的电子邮件地址

javax.validation.constraints.Future.message = 需要是一个将来的时间

javax.validation.constraints.FutureOrPresent.message = 需要是一个将来或现在的时间

javax.validation.constraints.Max.message = 最大不能超过{value}

javax.validation.constraints.Min.message = 最小不能小于{value}

javax.validation.constraints.Negative.message = 必须是负数

javax.validation.constraints.NegativeOrZero.message = 必须是负数或零

javax.validation.constraints.NotBlank.message = 不能为空

javax.validation.constraints.NotEmpty.message = 不能为空

javax.validation.constraints.NotNull.message = 不能为null

javax.validation.constraints.Null.message = 必须为null

javax.validation.constraints.Past.message = 需要是一个过去的时间

javax.validation.constraints.PastOrPresent.message = 需要是一个过去或现在的时间

javax.validation.constraints.Pattern.message = 需要匹配正则表达式"{regexp}"

javax.validation.constraints.Positive.message = 必须是正数

javax.validation.constraints.PositiveOrZero.message = 必须是正数或零

javax.validation.constraints.Size.message = 个数必须在{min}和{max}之间

org.hibernate.validator.constraints.CreditCardNumber.message = 不合法的信用卡号码

org.hibernate.validator.constraints.Currency.message = 不合法的货币 (必须是{value}其中之一)

org.hibernate.validator.constraints.EAN.message = 不合法的{type}条形码

org.hibernate.validator.constraints.Email.message = 不是一个合法的电子邮件地址

org.hibernate.validator.constraints.Length.message = 长度需要在{min}和{max}之间

org.hibernate.validator.constraints.CodePointLength.message = 长度需要在{min}和{max}之间

org.hibernate.validator.constraints.LuhnCheck.message = ${validatedValue}的校验码不合法, Luhn模10校验和不匹配

org.hibernate.validator.constraints.Mod10Check.message = ${validatedValue}的校验码不合法, 模10校验和不匹配

org.hibernate.validator.constraints.Mod11Check.message = ${validatedValue}的校验码不合法, 模11校验和不匹配

org.hibernate.validator.constraints.ModCheck.message = ${validatedValue}的校验码不合法, ${modType}校验和不匹配

org.hibernate.validator.constraints.NotBlank.message = 不能为空

org.hibernate.validator.constraints.NotEmpty.message = 不能为空

org.hibernate.validator.constraints.ParametersScriptAssert.message = 执行脚本表达式"{script}"没有返回期望结果

org.hibernate.validator.constraints.Range.message = 需要在{min}和{max}之间

org.hibernate.validator.constraints.SafeHtml.message = 可能有不安全的HTML内容

org.hibernate.validator.constraints.ScriptAssert.message = 执行脚本表达式"{script}"没有返回期望结果

org.hibernate.validator.constraints.URL.message = 需要是一个合法的URL

org.hibernate.validator.constraints.time.DurationMax.message = 必须小于${inclusive == true ? '或等于' : ''}${days == 0 ? '' : days += '天'}${hours == 0 ? '' : hours += '小时'}${minutes == 0 ? '' : minutes += '分钟'}${seconds == 0 ? '' : seconds += '秒'}${millis == 0 ? '' : millis += '毫秒'}${nanos == 0 ? '' : nanos += '纳秒'}

org.hibernate.validator.constraints.time.DurationMin.message = 必须大于${inclusive == true ? '或等于' : ''}${days == 0 ? '' : days += '天'}${hours == 0 ? '' : hours += '小时'}${minutes == 0 ? '' : minutes += '分钟'}${seconds == 0 ? '' : seconds += '秒'}${millis == 0 ? '' : millis += '毫秒'}${nanos == 0 ? '' : nanos += '纳秒'}自定义校验规则

- 校验注解

- 校验器

- 关联以上两个

<dependency>

<groupId>javax.validation</groupId>

<artifactId>validation-api</artifactId>

<version>2.0.1.Final</version>

</dependency>- 校验注解

@ListValue(vals={0, 1}, groups = {AddGroup.class, UpdateGroup.class})@Target({ METHOD, FIELD, ANNOTATION_TYPE, CONSTRUCTOR, PARAMETER, TYPE_USE })

@Retention(RUNTIME)

@Documented

@Constraint(validatedBy = {ListValueConstraintValidator.class}) // 关联,将该注解交给校验器校验,多个,不用类型使用,连接

public @interface ListValue {

String message() default "{com.ming.common.valid.ListValue.message}";

Class<?>[] groups() default { };

Class<? extends Payload>[] payload() default { };

int[] vals() default {};

}- 校验器

public class ListValueConstraintValidator implements ConstraintValidator<ListValue, Integer> {

private Set<Integer> set = new HashSet<>();

@Override

public void initialize(ListValue constraintAnnotation) {

int[] vals = constraintAnnotation.vals();

for(int val : vals) {

set.add(val);

}

}

/**

*

* @param value 需要校验的值

* @param context

* @return

*/

@Override

public boolean isValid(Integer value, ConstraintValidatorContext context) {

return set.contains(value);

}

}返回码

日志

@Slf4j

log.error("问题{},{}", e.getMessage(), e.getClass());事务

配置类(mybatis)上@EnableTransactionManagement // 开启事务

方法上@Transactional报错

Possibly consider using a shorter maxLifetime value

猜测也有可能是数据库的原因,没给对应的数据库配置

2021-02-03 23:48:40.633 WARN 9800 — [nio-8090-exec-4] com.zaxxer.hikari.pool.PoolBase : HikariPool-1 - Failed to validate connection com.mysql.cj.jdbc.ConnectionImpl@3a6d1822 (No operations allowed after connection closed.). Possibly consider using a shorter maxLifetime value.

spring:

datasource:

username: root

password: mingyuefusu!

url: jdbc:mysql://106.75.103.68:3306/gulimall_pms?serverTimezone=GMT%2B8&useUnicode=true&characterEncoding=utf-8

driver-class-name: com.mysql.cj.jdbc.Driver

hikari:

max-lifetime: 1800000配置

日期返回

#返回json的全局时间格式

spring.jackson.date-format=yyyy-MM-dd HH:mm:ss

spring.jackson.time-zone=GMT+8日志开启

logging:

level:

com.ming.gulimall: debugElasticSearch

商品属性

思考

分开还是合并

- spu和spu一起存,100万*2KB = 2GB

- 分开存

- 搜索小米:粮食、手机、电器,4000个spu对应属性,4000*8=32000B=32KB,10000人一起查=320000KB=320MB

库存数量

只用存是否存在,不需要存具体数量,不然每次都要更新索引

{

"gulimall_product": {

"mappings": {

"properties": {

"attrs": {

"type": "nested",

"properties": {

"attrId": {

"type": "long"

},

"attrName": {

"type": "keyword"

},

"attrValue": {

"type": "keyword"

}

}

},

"brandId": {

"type": "long"

},

"brandImg": {

"type": "keyword"

},

"brandName": {

"type": "keyword"

},

"catalogId": {

"type": "long"

},

"catalogName": {

"type": "keyword"

},

"hasStock": {

"type": "boolean"

},

"hotScore": {

"type": "long"

},

"saleCount": {

"type": "long"

},

"skuId": {

"type": "long"

},

"skuImg": {

"type": "keyword"

},

"skuPrice": {

"type": "double"

},

"skuTitle": {

"type": "text",

"analyzer": "ik_smart"

},

"spuId": {

"type": "keyword"

}

}

}

}

}PUT product

{

"mappings":{

"properties": {

"skuId":{

"type": "long"

},

"spuId":{

"type": "keyword"

},

"skuTitle": {

"type": "text",

"analyzer": "ik_smart"

},

"skuPrice": {

"type": "double"

},

"skuImg":{

"type": "keyword",

"index": false,

"doc_values": false

},

"saleCount":{

"type":"long"

},

"hasStock": {

"type": "boolean"

},

"hotScore": {

"type": "long"

},

"brandId": {

"type": "long"

},

"catalogId": {

"type": "long"

},

"brandName": {

"type": "keyword",

"index": false,

"doc_values": false

},

"brandImg":{

"type": "keyword",

"index": false,

"doc_values": false

},

"catalogName": {

"type": "keyword",

"index": false,

"doc_values": false

},

"attrs": {

"type": "nested",

"properties": {

"attrId": {

"type": "long"

},

"attrName": {

"type": "keyword",

"index": false,

"doc_values": false

},

"attrValue": {

"type": "keyword"

}

}

}

}

}

}压力测试

概念

压力测试考察当前软硬件环境下系统所能承受的最大负荷并帮助找岀系统瓶颈所在。

压测都是为了系统在线上的处理能力和稳定性维持在一个标准范围内,做到心中有数。

使用压力测试,我们有希望找到很多种用其他测试方法更难发现的错误。有两种错误类型是内存泄漏,并发与同步。

有效的压力测试系统将应用以下这些关键条件:重复,并发,量级,随机变化。

概念

- 响应时间RT:发请求开始,得到响应的整个时间

- HPS(Hit per Second):每秒点击次数

- TPS(Transaction per Second):每秒交易交易数

- QPS(Query per Second):每秒查询处理次数

金融:1000TPS~5000TPS

保险:100TPS~100000TPS

制造:10TPS~5000TPS

互联网电子商务:10000~1000000TPS

中型网站:1000~50000TPS

小型:500~10000TPS

最大响应时间:发出到响应最大时间

最少响应时间:发出的响应的最少时间

90%响应时间:响应时间排序,第90%名的响应时间

主要关注:

- 吞吐量:每秒系统能处理的请求数,任务数

- 响应时间:服务处理一个请求,一个任务的耗时

- 错误率:一批请求结果出错的比例

影响性能的考虑点:

数据库、应用程序、中间件(tomcat、Nginx)、网络和操作系统等

是CPU密集型还是IO密集型

Jmeter

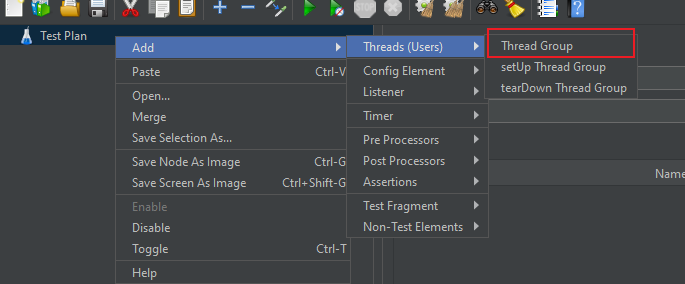

解压运行bin/jmeter.bat

使用

修改语言

新建线程

线程数、线程启动时间s,循环次数 /finite永远

高级设置:从html获取包含的资源,并行线程6

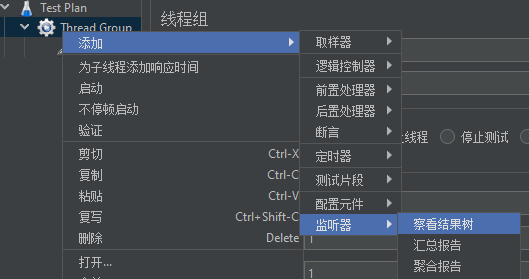

取样器

监听器

监听结果数(每一次的结果)、汇总报告(异常%,吞吐量)、聚合报告(平均响应时间、90%、最大最小)

JVM

调整堆,对象实例和数组都在堆分配,垃圾回收的朱啊哟区域,GC堆

堆:

新生代

- Eden

- From Survivor(与To来回交换)

- To Survivor

老年代

永久代(java8之前),java8后元空间,直接操作物理内存

过程

创建对象,进入新生代,看是否放得下,放不下就yGc(将eden的对象放到survivor,放不下或者存活了15岁就放到Old)中,如果还不行就放到老年代,老年代放不下,就Full GC(性能慢10倍),将新老都清理,还不行就内存溢出

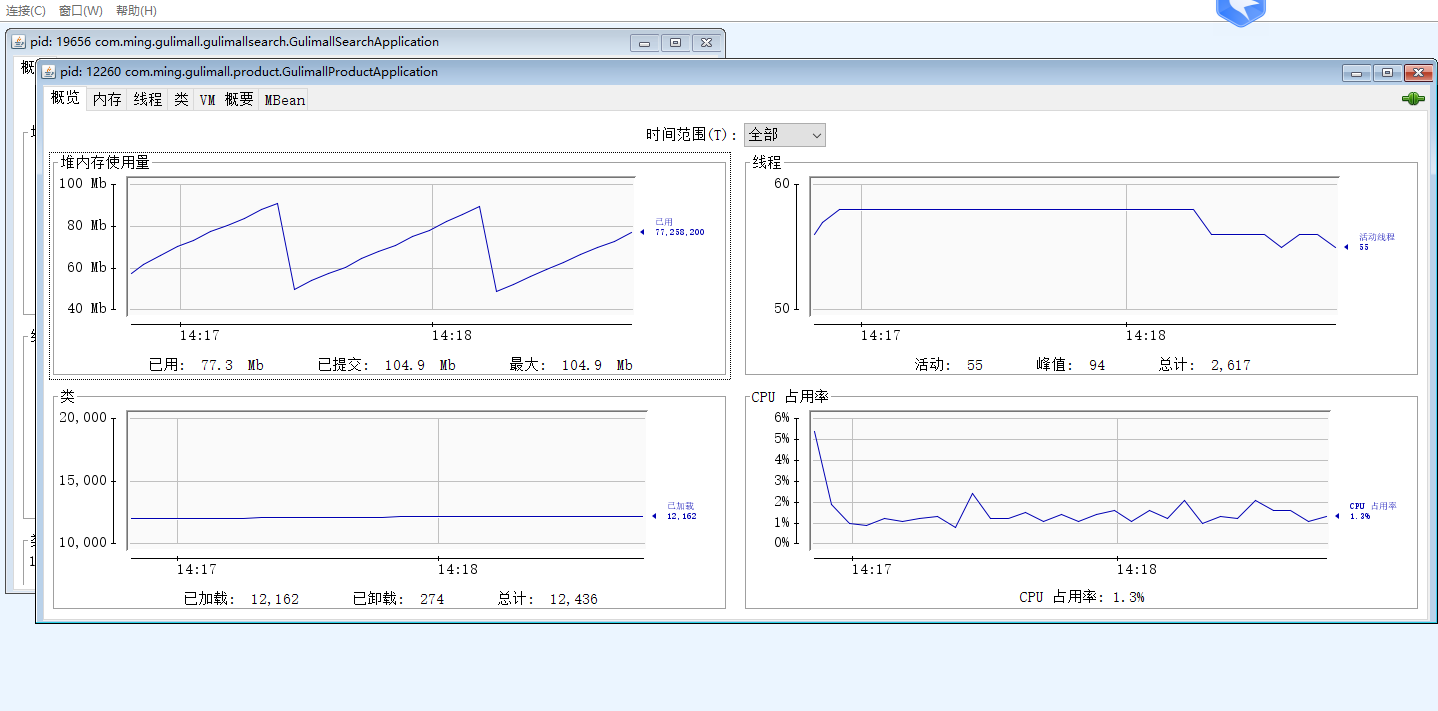

Jconsole

cmd jconsole,连接对应的应用

jvisualvm

jvisualvm(9后已经移除)监控,jconsole直接运行

下载:https://visualvm.github.io/download.html

运行

修改conf 添加 visualvm_jdkhome=”E:\eclipse”,运行即可

作用:监控内存泄露,跟踪垃圾回收,执行时内存、cpu分析,线程分析

状态

运行:正在运行的

休眠: sleep

等待:wait

驻留:线程池里面的空闲线程

监视:等待锁

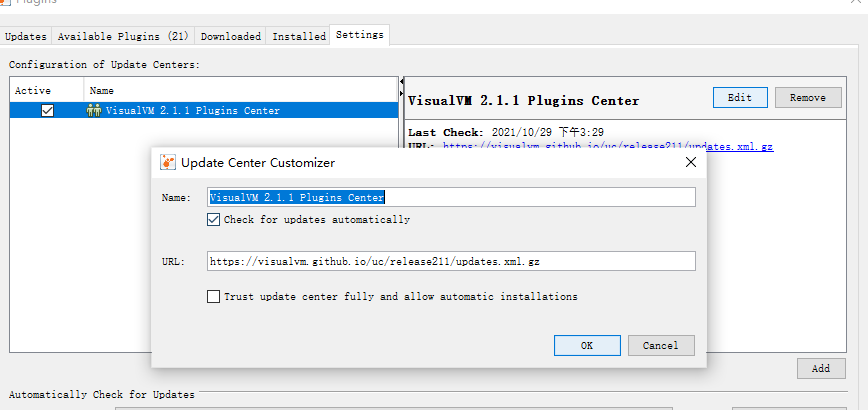

安装visual GC插件方便查看gc、安装插件可能存在更新问题,设置修改对应的版本,java -version,根据版本号https://visualvm.github.io/pluginscenters.html在里面换对应的地址,如下:

主要看Monitor、visual GC

可以用 -Xmx1024m -Xms1024m -Xmn512m增大内存

-Xmx最大 -Xms最小 -Xmn 新生代+幸存者区

-Xmx100m

优化步骤

- 页面缓存(thymeleaf)

- 增加内存(vm optiion: -Xmx512m)

- 业务优化(数据库查找、加普通索引)

- 关闭日志输出

- 动静分离

- 去掉中间层(nginx+gateway多层会变慢)

测试结果

中间件越多,性能损失越大,网络交互

| 压测内容 | 压测线程数 | 吞吐量/s | 90%响应时间 | 99%响应时间 |

|---|---|---|---|---|

| Nginx | 50 | 3606 | 19 | 146 |

| Gateway | 50 | 5751 | 18 | 38 |

| 简单服务 | 50 | 10000 | 5 | 15 |

| 首页一级菜单渲染 | 50 | 350(db,thymeleaf) | 270 | 540 |

| 首页渲染(开缓存) | 50 | 400 | 185 | 350 |

| 首页渲染(开缓存,优化数据库,关日志) | 50 | 750 | 157 | 333 |

| 三级分类数据获取 | 50 | 3(db)/ 8(加索引) | … | … |

| 三级分类(优化业务) | 50 | 94(db)/ 8(加索引) | 1000 | 1600 |

| 首页全量数据获取 | 50 | 12(静态资源) | ||

| Nginx+Gateway | 50 | |||

| Gateway+简单服务 | 50 | 2340 | 44 | 64 |

| 全链路 | 50 | 600 | 129 | 395 |

error

socket close: 手动关闭

Address already in use: connect

原因: windows提供TCP/IP端口为1024-50000,十分钟循环回收,短时间内大量请求将端口占满

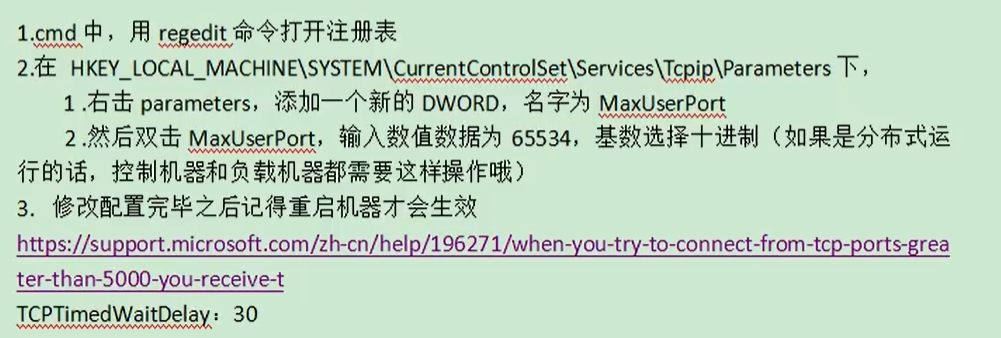

1. 打开注册表:regedit

2. HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Services\TCP\Parameters

3. 新建 DWORD值,name:TcpTimedWaitDelay,value:30(十进制) –> 设置为30秒,默认是240

4. 新建 DWORD值,name:MaxUserPort,value:65534(十进制) –> 设置最大连接数65534

5. 重启系统Redis

为了系统性能的提升,我们一般都会将部分数据放入缓存中,加入访问,而db承担数据持久化工作

适合放入缓存的数据

- 对及时性、数据一致性要求不高的

- 访问量大且更新频率不高的数据

1) 使用hashmap本地缓存

缺点:重启就没了,分布式下存在多份

//测试本地缓存,通过hashmap

private Map<String,Object> cache = new HashMap<>();

public Map<String, List<Catalog2Vo>> getCategoryMap() {

Map<String, List<Catalog2Vo>> catalogMap =

(Map<String, List<Catalog2Vo>>) cache.get("catalogMap");

//如果没有缓存,则从数据库中查询并放入缓存中

if (catalogMap == null) {

catalogMap = getCategoriesDb();

cache.put("catalogMap",catalogMap);

}

return catalogMap;

}初始化

内存泄露在2.3版本修复

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-redis</artifactId>

<exclusions>

<exclusion>

<groupId>io.lettuce</groupId>

<artifactId>lettuce-core</artifactId>

</exclusion>

</exclusions>

</dependency>

<dependency>

<groupId>redis.clients</groupId>

<artifactId>jedis</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-redis</artifactId>

</dependency>配置

spring:

redis:

host: #

port: 6379

password:简单使用

@Autowired

StringRedisTemplate stringRedisTemplate;

ValueOperations<String, String> ops = stringRedisTemplate.opsForValue();

String catalogJson = ops.get("catalogJson", catalogJson, 1, TimeUnit.DAYS);

// json序列化

ops.set("catalogJson", JSON.toJSONString(categoriesDb););

// 反序列化

Map<String, List<Catalog2Vo>> listMap = JSON.parseObject(

catalogJson,

new TypeReference< Map< String, List<Catalog2Vo> > >() {}

);OutOfDirectMemoryError

当进行压力测试时后期后出现堆外内存溢出OutOfDirectMemoryError,堆外内存溢出

产生原因:

1)、springboot2.0以后默认使用 lettuce 操作redis的客户端,5.2没事,它使用 netty 进行网络通信

2)、lettuce的bug导致netty堆外内存溢出,默认-Xmx300m

解决方案:由于是lettuce的bug造成,可以使用-Dio.netty.maxDirectMemory去调大虚拟机堆外内存,但是还是会出现

1)、升级lettuce客户端,引入5.2.*,5.2.0.RELEASE

2)、切换使用jedis,去掉lettuce-core

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-redis</artifactId>

<exclusions>

<exclusion>

<groupId>io.lettuce</groupId>

<artifactId>lettuce-core</artifactId>

</exclusion>

</exclusions>

</dependency>

<dependency>

<groupId>redis.clients</groupId>

<artifactId>jedis</artifactId>

</dependency>基本操作

// RedisTemplate、StringRedisTemplate

// 1.opsFor

StringRedisTemplate redisTemplate;

redisTemplate.opsForValue();

get().set();

opsForHash();

opsForList();

opsForSet();

opsForZSet();

opsForGeo();

opsForHyperLogLog();

// 2.bound直接操作 举例,这是操作Hash类型数据的,也就是键key对应的value值是

BoundHashOperations<String, Object, Object> operation = redisTemplate.boundHashOps(cartKey);

// fastJSON

Map<String, List<Catalog2Vo>> categoriesDb;

// 序列化

String toJSONString = JSON.toJSONString(categoriesDb);

// 反序列化

Map<String, List<Catalog2Vo>> listMap = JSON.parseObject(

catalogJson,

new TypeReference< Map<String, List<Catalog2Vo>> >() {}

);

缓存穿透

指查询一个一定不存在的数据,由于缓存是不命中,将去查询数据库,但是数据库也无此记录,我们没有将这次查询的null写入缓存,这将导致这个不存在的数据每次请求都要到存储层去查询,失去了缓存的意义

风险:

利用不存在的数据进行攻击,数据库瞬时压力增大,最终导致崩溃

解决:

null结果缓存,并加入短暂过期时间

缓存雪崩

缓存雪崩是指在我们设置缓存时key采用了相同的过期时间,导致缓存在某一时刻同时失效,请求全部转发到DB,DB瞬时压力过重雪崩。

解决:

原有的失效时间基础上增加一个随机值,比如1-5分钟随机,这样每一个缓存的过期时间的重复率就会降低,就很难引发集体失效的事件。

缓存击穿与最佳逻辑

对于一些设置了过期时间的key,如果这些key可能会在某些时间点被超高并发地访问,是一种非常“热点”的数据。

如果这个key在大量请求同时进来前正好失效,那么所有对这个key的数据查询都落到db,我们称为缓存击穿。

解决:

加锁。大量并发只让一个去查,其他人等待,查到以后释放锁,其他人获取到锁,先查缓存,就会有数据,不用去db

// 本地锁:最佳逻辑,虽然分布式下每个服务都会查询DB

if( !getCache() ) { // 没有缓存

synchronized( this ) { // 加锁查数据库

if( !getCache() ) { // 再次确认没有缓存,避免释放锁后,还未来得及放入缓存,多次查询数据库

getDb();

setCache();

}

return

}

}

return

// 0、通常, 存在缓存击穿问题

getCache();

if( !getCache() ) { // 没缓存

getDb();

setCache();

}

return data;

// 1、本地加锁

getCache();

if( !getCache() ) { // 没缓存

synchronized( this ) { // 同时都在排队等待查询数据库,存在问题

getDb();

}

setCache();

}

// 1.1 加锁、查询前再进行一次cache查找

getCache();

if( !getCache() ) { // 没缓存

synchronized( this ) { // 同时都在排队等待查询数据库

if( !getCache() ) { // 每次只进来一个,所以理论上只会查询一次数据库,实际上可能存在cache未存入就进来的情况

getDb();

setCache();

return ;

}

}

}

return ;

// springboot 中所有组件在容器中都是单例的

synchronized( this ) { // 单体有效,分布式无效,还会有多个线程进入查询数据库

// 得到锁应该去缓存中确定一次,因为没有得到锁的 还在是排队查数据库

}

// 这种情况下可能存在释放锁还没放缓存前多次查数据库

private synchronized Map<String, List<Catalog2Vo>> getCategoriesDb() {

return listMap;

}分布式下idea:program arguments: --server.port=10001

setnx

分布式锁

当有多个服务存在时,每个服务的缓存仅能够为本服务使用,这样每个服务都要查询一次数据库,并且当数据更新时只会更新单个服务的缓存数据,就会造成数据不一致的问题,所有的服务都到同一个redis进行获取数据,就可以避免这个问题

setIfAbsent(“lock-name”, “value”, 5, TimeUnit.SECONDS)

stringRedisTemplate.opsForValue().setIfAbsent("lock", "1111",5, TimeUnit.SECONDS);

// 确保redis无数据,从数据库查询数据并保存到redis

public Map<String, List<Catalog2Vo>> getCategoryMap() {

ValueOperations<String, String> ops = stringRedisTemplate.opsForValue();

String catalogJson = ops.get("catalogJson");

if (StringUtils.isEmpty(catalogJson)) {

System.out.println("缓存不命中,准备查询数据库。。。");

Map<String, List<Catalog2Vo>> categoriesDb= getCategoriesDb();

String toJSONString = JSON.toJSONString(categoriesDb);

ops.set("catalogJson", toJSONString);

return categoriesDb;

}

System.out.println("缓存命中。。。。");

Map<String, List<Catalog2Vo>> listMap = JSON.parseObject(catalogJson, new TypeReference<Map<String, List<Catalog2Vo>>>() {});

return listMap;

}// 分布式锁情况下,查询数据

public Map<String, List<Catalog2Vo>> getCatalogJsonDbWithRedisLock() {

// 1.

// Boolean lock = stringRedisTemplate.opsForValue().setIfAbsent("lock", "111");

// 2. set lock 1111 EX 300 NX 设置锁的同时设置过期时间

Boolean lock = stringRedisTemplate.opsForValue().setIfAbsent("lock", "1111",5, TimeUnit.SECONDS);

if (lock) {

// 1.设置过期时间,但是如果断电就死锁

// stringRedisTemplate.expire("lock", 30, TimeUnit.SECONDS);

Map<String, List<Catalog2Vo>> categoriesDb = getCategoryMap();

stringRedisTemplate.delete("lock");

return categoriesDb;

}else {

try {

Thread.sleep(100);

} catch (InterruptedException e) {

e.printStackTrace();

}

return getCatalogJsonDbWithRedisLock();

}

}删除锁直接删除???

如果由于业务时间很长,锁自己过期了,我们直接删除,有可能把别人正在持有的锁删除了。

解决:

占锁的时候,值指定为uuid,每个人匹配是自己的锁才删除。

public Map<String, List<Catalog2Vo>> getCatalogJsonDbWithRedisLock() {

String uuid = UUID.randomUUID().toString();

ValueOperations<String, String> ops = stringRedisTemplate.opsForValue();

// 为当前锁设置唯一的uuid,只有当uuid相同时才会进行删除锁的操作

Boolean lock = ops.setIfAbsent("lock", uuid,5, TimeUnit.SECONDS);

if (lock) {

Map<String, List<Catalog2Vo>> categoriesDb = getCategoryMap();

String lockValue = ops.get("lock");

if (lockValue.equals(uuid)) { // 注意:存在问题,如果传输回来的过程中过期了就还会删完

try {

Thread.sleep(6000);

} catch (InterruptedException e) {

e.printStackTrace();

}

stringRedisTemplate.delete("lock");

}

return categoriesDb;

}else {

}如果传输回来的过程中过期了就还会删完,因为查找和删除不是原子操作

解决:

删除锁必须保证原子性。使用redis+Lua脚本完成

最佳实践

public Map<String, List<Catalog2Vo>> getCatalogJsonDbWithRedisLock() {

String uuid = UUID.randomUUID().toString();

ValueOperations<String, String> ops = stringRedisTemplate.opsForValue();

Boolean lock = ops.setIfAbsent("lock", uuid, 50, TimeUnit.SECONDS);

if (lock) {

Map<String, List<Catalog2Vo>> categoriesDb = getCategoryMap();

try{

getDataFromDb();

} finally {

// 避免自己的锁过期了,误删别人的锁

// 如果使用java,判断是自己的没过期,但是删除的时候已经过期了,还会删除别人的,所以查询和删除要原子性

String script = "if redis.call(\"get\",KEYS[1]) == ARGV[1] then\n" +

" return redis.call(\"del\",KEYS[1])\n" +

"else\n" +

" return 0\n" +

"end";

stringRedisTemplate.execute(

new DefaultRedisScript<Long>( // 返回值类型

script,

Long.class

),

Arrays.asList("lock"), // keys[1]

uuid // argv[1]

);

}

return categoriesDb;

}else {

try {

Thread.sleep(100);

} catch (InterruptedException e) {

e.printStackTrace();

}

return getCatalogJsonDbWithRedisLock(); // 注意;递归容易栈溢出

}

}保证加锁【占位+过期时间】和删除锁【判断+删除】的原子性。更难的事情,锁的自动续期

Redssion

Redisson

与GUC类似

简介

Redisson是一个在Redis的基础上实现的Java驻内存数据网格(In-Memory Data Grid)。它不仅提供了一系列的分布式的Java常用对象,还提供了许多分布式服务。其中包括(BitSet, Set, Multimap, SortedSet, Map, List, Queue, BlockingQueue, Deque, BlockingDeque, Semaphore, Lock, AtomicLong, CountDownLatch, Publish / Subscribe, Bloom filter, Remote service, Spring cache, Executor service, Live Object service, Scheduler service)

Redisson提供了使用Redis的最简单和最便捷的方法。

Redisson的宗旨是促进使用者对Redis的关注分离(Separation of Concern),从而让使用者能够将精力更集中地放在处理业务逻辑上。

本文我们仅关注分布式锁的实现,更多请参考官方文档

可重入锁

(Reentrant Lock),A方法中调用B方法,A、B都要抢同一个锁,这个锁必须是同重入锁

RLock lock = redissonClient.getLock("CatalogJson-Lock");

lock.lock();

lock.unlock();public Map<String, List<Catalog2Vo>> getCatalogJsonDbWithRedisson() {

Map<String, List<Catalog2Vo>> categoryMap=null;

RLock lock = redissonClient.getLock("CatalogJson-Lock");

// lock.lock(10, TimeUnit.SECONDS); // 没有自动续期,一定要大于业务的时间,并且unlock可能无法删除

// 1. 如果传递超时时间,就给redis发送执行脚本,进行占锁,默认超时就是我们的时间

// 2. 未指定时间,默认使用30秒时间,占锁成功启动定时任务(重新给锁设定行的过期时间),【看门狗时间】 / 3 一次续期,续成满时间

lock.lock();

// boolean res = lock.tryLock(100, 10, TimeUnit.SECODS); // 最多等待100秒,上锁10秒后自动解锁

//if(res)

try {

Thread.sleep(30000);

categoryMap = getCategoryMap();

} catch (InterruptedException e) {

e.printStackTrace();

} finally {

lock.unlock(); // 默认30秒过期,业务时间长,会检查服务是否运行,自动续时

return categoryMap;

}

}公平锁

getFairLock(“”)

读写锁

(ReadWriteLock),写锁会阻塞读锁,但是读锁不会阻塞读锁,但读锁会阻塞写锁

可多读、但仅一写且无读

RReadWriteLock lock = redissonClient.getReadWriteLock("ReadWrite-Lock");

lock.readLock().lock();

lock.writeLock().lock();@GetMapping("/read")

@ResponseBody

public String read() {

RReadWriteLock lock = redissonClient.getReadWriteLock("ReadWrite-Lock");

RLock rLock = lock.readLock();

String s = "";

try {

rLock.lock();

System.out.println("读锁加锁"+Thread.currentThread().getId());

Thread.sleep(5000);

s= redisTemplate.opsForValue().get("lock-value");

}finally {

rLock.unlock();

return "读取完成:"+s;

}

}

@GetMapping("/write")

@ResponseBody

public String write() {

RReadWriteLock lock = redissonClient.getReadWriteLock("ReadWrite-Lock");

RLock wLock = lock.writeLock();

String s = UUID.randomUUID().toString();

try {

wLock.lock();

System.out.println("写锁加锁"+Thread.currentThread().getId());

Thread.sleep(10000);

redisTemplate.opsForValue().set("lock-value",s);

} catch (InterruptedException e) {

e.printStackTrace();

}finally {

wLock.unlock();

return "写入完成:"+s;

}

}信号量

Semaphore

信号量为存储在redis中的一个数字,当这个数字大于0时,即可以调用acquire()方法增加数量,也可以调用release()方法减少数量,但是当调用release()之后小于0的话方法就会阻塞,直到数字大于0

RSemaphore park = redissonClient.getSemaphore("park");

park.acquire(2);

park.release(2);

boolean flag = park.tryAcquire(2); // 尝试获取闭锁

(CountDownLatch)

可以理解为门栓,使用若干个门栓将当前方法阻塞,只有当全部门栓都被放开时,当前方法才能继续执行。

以下代码只有offLatch()被调用5次后 setLatch()才能继续执行

RCountDownLatch latch = redissonClient.getCountDownLatch("CountDownLatch");

latch.trySetCount(5); // 5个都有

latch.await(); // 进行等待

latch.countDown(); // 释放加锁最好细粒度,名字为product-11-lock

分布式锁,微服务架构下

@Configuration

public class RedissonConfig {

@Bean

public RedissonClient redissonClient(){

Config config = new Config();

config.useSingleServer().setAddress("redis://192.168.56.102:6379");

RedissonClient redisson = Redisson.create(config);

return redisson;

}

}依赖、配置

<dependency>

<groupId>org.redisson</groupId>

<artifactId>redisson</artifactId>

<version>3.13.4</version>

</dependency>@Configuration

public class RedissonConfig {

@Bean(destroyMethod="shutdown")

RedissonClient redisson() throws IOException {

Config config = new Config();

// Redis url should start with redis:// or rediss://(ssl)

config.useClusterServers()

.addNodeAddress("redis:127.0.0.1:6379"");

return Redisson.create(config);

}

}命名

细粒度锁:

product-id-lock

基本方法

RLock lock = redission.getLock("lockname");

lock.lock(); // 阻塞,能够自动续期,默认30秒,启动定时任务,每10s续期

// 推荐,省去续期

lock.lock(10, TimeUnit.SECONDS); // 自动解锁,要保证业务时间在范围内,否则可能解开别人的锁

try {} catch() {} finally{ }

lock.unLock();

// 尝试加锁,最多等待100s,10秒后解锁

boolean res = lock.tryLock(100, 10, TimeUnit.SECONDS);

// 公平

redission.getFairLock("");

// 读写锁

rwLock = redission.getReadWriteLock();

rLock = rwLock.readLock();

wLock = rwLock.writeLock();

lock.lock();

// 信号量

RSemaphore semaphore = redission.getSemaphore("lock");

semaphore.acquire();

semaphore.tryAcquire(); // 限流

semaphore.release();

// 闭锁,所有都做完,班级走完才关大门

RCountDownLatch latch = redission.getCountDownLatch("lock");

latch.trySetCount(5); // 有5个班级

latch.await(); // 等待走完

RCountDownLatch latch = redission.getCountDownLatch("lock");

latch.countDown(); // 走了一个班级缓存数据的一致性

双写模式@CachePut

简介:当数据更新时,更新数据库时同时更新缓存

存在问题

脏数据,A写db、redis中间包裹另B写db、redis

这是暂时性的脏数据问题,但是在数据稳定,缓存过期以后,又能得到最新的正确数据

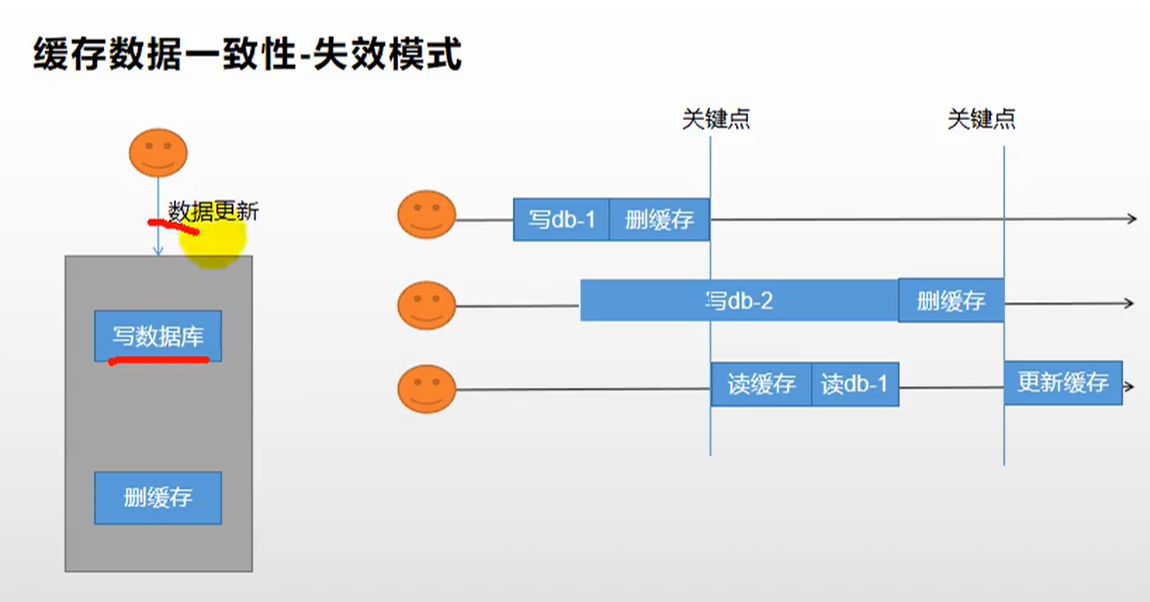

失效模式@CacheEvict

简介:数据库更新时将缓存删除

存在问题,脏数据,最终一致

当两个请求同时修改数据库,一个请求已经更新成功并删除缓存时又有读数据的请求进来,这时候发现缓存中无数据就去数据库中查询并放入缓存,在放入缓存前第二个更新数据库的请求成功,这时候留在缓存中的数据依然是第一次数据更新的数据

解决方案

无论是双写模式还是失效模式,都会导致缓存的不一致问题。即多个实例同时更新会出事。怎么办?

- 如果是用户纬度数据(订单数据、用户数据),这种并发几率非常小,不用考虑这个问题,缓存数据加上过期时间,每隔一段时间触发读的主动更新即可

- 如果是菜单,商品介绍等基础数据,也可以去使用canal(大数据量)订阅binlog的方式。

- 缓存数据+过期时间也足够解决大部分业务对于缓存的要求。

- 通过加锁保证并发读写, 写写的时候按顺序排好队。读读无所谓。所以适合使用读写锁。(业务不关心脏数据,允许临时脏数据可忽略);

总结:

- 我们能放入缓存的数据本就不应该是实时性、一致性要求超高的。所以缓存数据的时候加上过期时间,保证每天拿到当前最新数据即可。

- 我们不应该过度设计,增加系统的复杂性

- 遇到实时性、一致性要求高的数据,就应该查数据库,即使慢点。

- 当个用户数据并发几率小,过期时间自动过期即可

- 菜单、商品介绍基础数据(允许不一致性),可以使用canal订阅binlog方式。

- 缓存加过期时间满足大部分业务

- 读写锁保证并发读写

canal

- 更新缓存(cannal订阅binlog,更新redis)

- 数据异构,聚合生成新的数据(推荐商品)

SpringCache

实现:AOP,默认无加锁,sync=true整个过程加本地锁

存在缓存击穿

cacheManager用来定义规则,cache的遵守的规则

初始化

原理:

CacheAutoConfiguration -> RedisCacheConfiguration -> 自动配置了RedisCacheManager - > 初始化所有缓存 -> 每个缓存决定使用什么配置

-> 如果RedisCacheConfiguration有就用已有的,没有就用默认配置

1) 导入依赖

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-cache</artifactId>

</dependency>2) 自定义配置

指定缓存类型并在主配置类上加上注解@EnableCaching

spring:

cache:

#指定缓存类型为redis

type: redis

redis:

# 指定redis中的过期时间为1h

time-to-live: 3600000

# 一般不定义,让分区名就是缓存的前缀,这样可以统一操作分区

# key-prefix: CACHE_SWZL

# 是否使用前缀

use-key-prefix: true

# 是否存空值

cache-null-values: true默认使用jdk进行序列化,默认缓存名字:simplyKey [],默认使用jdk序列化机制,保存到redis,ttl -1,默认永久,自定义序列化方式需要编写配置类

- 指定key

- 序列化为JSON

- 配置过期时间

@EnableConfigurationProperties(CacheProperties.class) // 导入原来的配置属性

@Configuration

@EnableCaching

public class MyCacheConfig {

@Bean

public org.springframework.data.redis.cache.RedisCacheConfiguration redisCacheConfiguration(

CacheProperties cacheProperties) {

CacheProperties.Redis redisProperties = cacheProperties.getRedis();

org.springframework.data.redis.cache.RedisCacheConfiguration config = org.springframework.data.redis.cache.RedisCacheConfiguration

.defaultCacheConfig();

// 指定缓存序列化方式为json

config = config.serializeValuesWith(

RedisSerializationContext.SerializationPair.fromSerializer( new GenericJackson2JsonRedisSerializer() )

);

// 设置配置文件中的各项配置,如过期时间

if (redisProperties.getTimeToLive() != null) {

config = config.entryTtl(redisProperties.getTimeToLive());

}

if (redisProperties.getKeyPrefix() != null) {

config = config.prefixKeysWith(redisProperties.getKeyPrefix());

}

if (!redisProperties.isCacheNullValues()) {

config = config.disableCachingNullValues();

}

if (!redisProperties.isUseKeyPrefix()) {

config = config.disableKeyPrefix();

}

return config;

}

}spel表达式

缓存注解

Cacheable 添加

@Cacheable(value = {"category"}, key = "'cacheKey'") // ''使用字符串根据方法对其返回结果进行缓存,下次请求时,如果缓存存在,则直接读取缓存数据返回;如果缓存不存在,则执行方法,并把返回的结果存入缓存中。一般用在查询方法上。

查看源码,属性值如下:

| 属性/方法名 | 解释 |

|---|---|

| value | 缓存名,必填,它指定了你的缓存存放在哪块命名空间 |

| cacheNames | 与 value 差不多,二选一即可 |

| key | 可选属性,可以使用 SpEL 标签自定义缓存的key |

| sync | true,使用锁 |

CachePut 修改

使用该注解标志的方法,每次都会执行,并将结果存入指定的缓存中。其他方法可以直接从响应的缓存中读取缓存数据,而不需要再去查询数据库。一般用在新增方法上。

查看源码,属性值如下:

| 属性/方法名 | 解释 |

|---|---|

| value | 缓存名,必填,它指定了你的缓存存放在哪块命名空间 |

| cacheNames | 与 value 差不多,二选一即可 |

| key | 可选属性,可以使用 SpEL 标签自定义缓存的key |

CacheEvict 删除

@CacheEvict(value = "category", key = "'methodName'")

@Cacheable(value = {"category"}, key = "#root.method.name")

@CacheEvict(value = "category", allEntries = true) // 删除所有category部分使用该注解标志的方法,会清空指定的缓存。一般用在更新或者删除方法上

查看源码,属性值如下:

| 属性/方法名 | 解释 |

|---|---|

| value | 缓存名,必填,它指定了你的缓存存放在哪块命名空间 |

| cacheNames | 与 value 差不多,二选一即可 |

| key | 可选属性,可以使用 SpEL 标签自定义缓存的key |

| allEntries | 是否清空所有缓存,默认为 false。如果指定为 true,则方法调用后将立即清空value下的所有的缓存 |

| beforeInvocation | 是否在方法执行前就清空,默认为 false。如果指定为 true,则在方法执行前就会清空缓存 |

Caching 多操作

进行多种缓存操作

@Caching(evict = {

@CacheEvict( value = "category", key = "'getLevel2'"),

@CacheEvict( value = "category", key = "'getLevel1'" )

})CacheConfig

不足

常规数据(读多写少,及时性、一致性不高的数据完全可以用spring-cache

读模式

缓存穿透: 查询null数据,解决:spring.cache.redis.cache-null-values=true

缓存击穿:缓存过期后,大量请求突然涌入,解决:加synchronized锁(sync=true,貌似是锁对象),默认无加锁

缓存雪崩:缓存集体失效,解决:加随机时间

写模式

缓存与数据库一致

读写加锁:适合多读少写

引入Canal,感知MySQL的更新去更新

读多写多,直接查DB

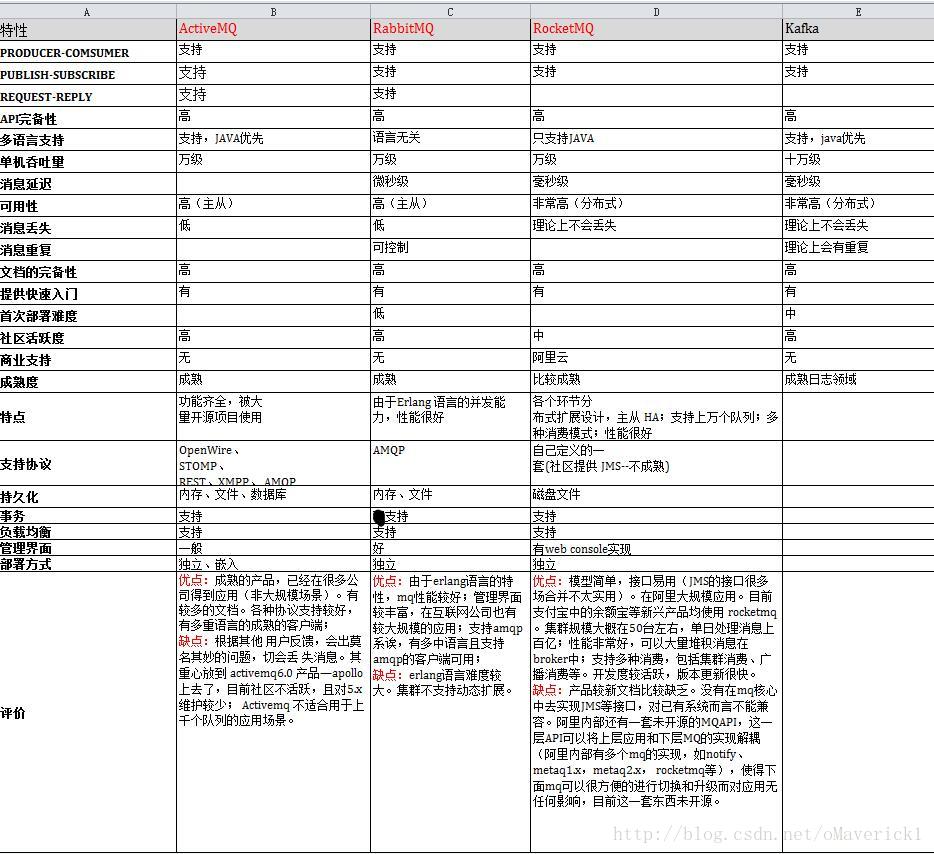

RabbitMQ

学习文档:https://niceseason.github.io/2020/04/18/springboot/#%E4%BA%8C%E3%80%81RabbitMQ

官网:https://www.rabbitmq.com/documentation.html

异步、流量控制(消峰)、解耦

RabbitMQ是一个由erlang开发的AMQP(Advanved Message Queue Protocol)的开源实现

rocketmq开源版本功能不够完善

AMQP、rabbitMq高性能、高并发、高可用、数据处理量不错、开源、多语言

kafka性能高、但是可能会重发

下载

官网:

https://github.com/erlang/otp/releases?page=3

https://www.rabbitmq.com/install-windows.html

软件

https://github.com/erlang/otp/releases/download/OTP-23.3.4.14/otp_win64_23.3.4.14.exe

https://github.com/rabbitmq/rabbitmq-server/releases/download/v3.9.19/rabbitmq-server-3.9.19.exe

(太新的erlang也要更新)

安装目录下 E:\environment\rabbitmq\rabbitmq_server-3.9.19\sbin

port: 15672

rabbitmqctl start_app

rabbitmqctl stop

# 可视化插件

rabbitmq-plugins enable rabbitmq_management

guest/guest

# 使用命令添加用户并授权

# 添加用户

rabbitmqctl add_user admin admin

# 设置permissions

rabbitmqctl set_permissions -p "/" admin ".*" ".*" ".*"

# 设置用户角色

rabbitmqctl set_user_tags admin administrator

# 查看新添加的admin

rabbitmqctl list_users

# 查看用于的权限

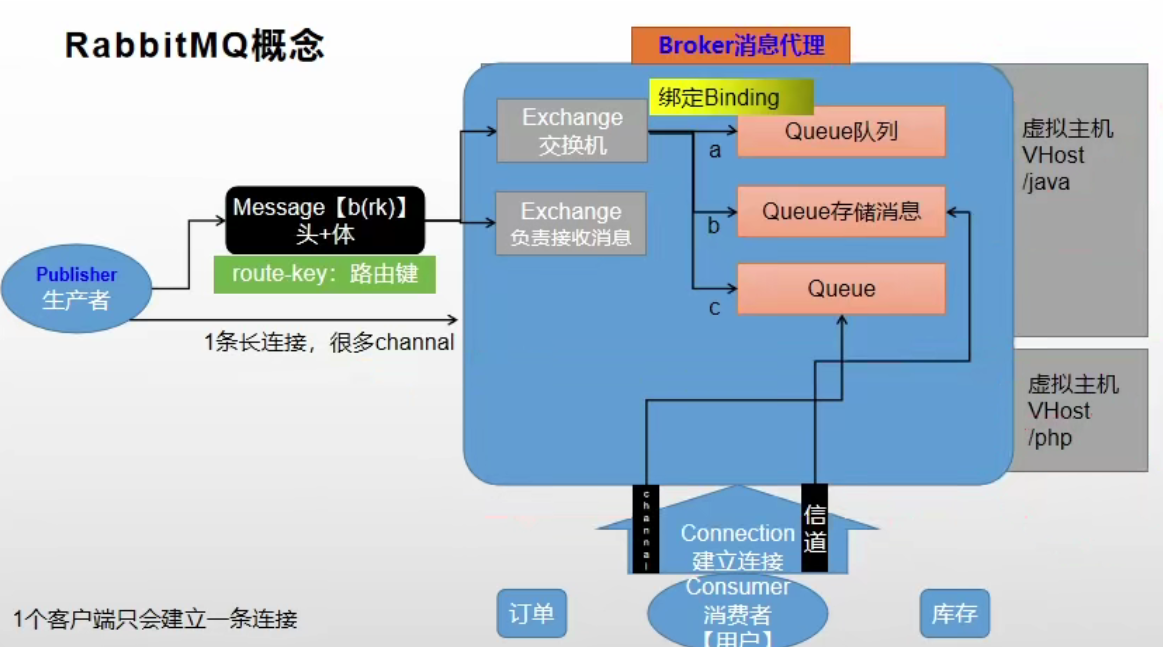

rabbitmqctl list_permissions -p /核心概念

- Message

- 消息,消息是不具名的,它由消息头和消息体组成

- 消息头,包括routing-key(路由键)、priority(相对于其他消息的优先权)、delivery-mode(指出该消息可能需要持久性存储)等

- Publisher

- 消息的生产者,也是一个向交换器发布消息的客户端应用程序

- Exchange

- 交换器,将生产者消息路由给服务器中的队列

- 类型有direct(默认),fanout, topic, 和headers,具有不同转发策略

- Queue

- 消息队列,保存消息直到发送给消费者

- Binding

- 绑定,用于消息队列和交换器之间的关联

- Connection

- 网络连接,比如一个TCP连接

- Consumer

- 消息的消费者,表示一个从消息队列中取得消息的客户端应用程序

- Virtual Host

- 虚拟主机,表示一批交换器、消息队列和相关对象。

- vhost 是 AMQP 概念的基础,必须在连接时指定

- RabbitMQ 默认的 vhost 是 /

- Broker

- 消息队列服务器实体

- channel

- 建立一条连接,有很多通道

运行机制

消息路由

AMQP 中增加了Exchange 和 Binding 的角色, Binding 决定交换器的消息应该发送到那个队列

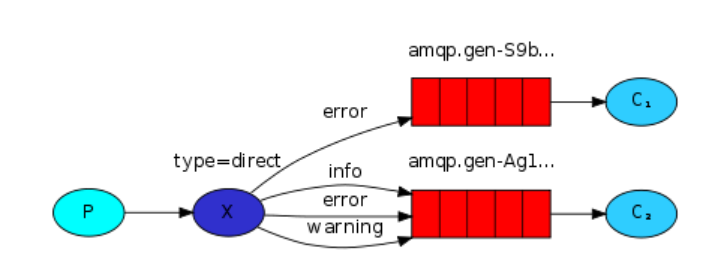

Exchange 类型

direct

点对点模式,消息中的路由键(routing key)如果和 Binding 中的 binding

key 一致, 交换器就将消息发到对应的队列中。fanout

广播模式,每个发到 fanout 类型交换器的消息都会分到所有绑定的队列上去

topic

将路由键和某个模式进行匹配,此时队列需要绑定到一个模式上。它将路由键和绑定键的字符串切分成单词,这些单词之间用点隔开。

识别通配符: # 匹配 0 个或多个单词, *匹配一个单词

初始化

amqp:5672、5671

http,web端口:15672

clustering:25672

4369,25672:erlang发现&集群端口

1883,8883:MQTT协议端口

# for RabbitMQ 3.9, the latest series

docker run \

--ip 192.168.0.9 --net mynet \

-it --rm -d \

--name rabbitmq \

-p 5672:5672 \

-p 15672:15672 rabbitmq:3.9-management

docker run \

-it --rm -d \

--name rabbitmq \

-p 5672:5672 \

-p 15672:15672 rabbitmq:3.9-management

# for RabbitMQ 3.8,

# https://www.rabbitmq.com/versions.html

docker run -it --rm --name rabbitmq -p 5672:5672 -p 15672:15672 rabbitmq:3.8-management

docker update rabbitmq --restart=always队列模式

https://www.rabbitmq.com/getstarted.html

这里写的太烂了

简单队列

点对点,交换机对应一个队列(一个路由)

简单

生产的很多,可能内存溢出

send

public class Send {

private final static String QUEUE_NAME = "hello";

public static void main(String[] argv) throws Exception {

ConnectionFactory factory = new ConnectionFactory();

factory.setHost("101.227.11.219");

factory.setUsername("root");

factory.setPassword("");

factory.setVirtualHost("/ming");

factory.setPort(5672);

try (

Connection connection = factory.newConnection();

Channel channel = connection.createChannel()

) {

channel.queueDeclare(

QUEUE_NAME, // 名称

false, // 持久化

false, // 排他队列,基于连接下,可以访问,不可重名,关闭连接,也会删除

/*

1.基于连接可见,同一连接下的不同通道可以访问同一连接下的其他排它队列

2.基于连接创建,连接下排它队列不可同名

3.即使是持久化的,连接关闭则排它队列删除

只限于一个客户端发送读取消息场景

*/

false, // 自动删除,如果没有消费者则删除

null

);

String message = "Hello World!";

// 交换机、路由、是否持久化、消息内容

channel.basicPublish(

"",

QUEUE_NAME,

null,

message.getBytes(StandardCharsets.UTF_8)

);

System.out.println(" [x] Sent '" + message + "'");

}

}

}

recv

public class Recv {

private final static String QUEUE_NAME = "hello";

public static void main(String[] argv) throws Exception {

ConnectionFactory factory = new ConnectionFactory();

factory.setHost("101.227.11.219");

factory.setUsername("root");

factory.setPassword("");

factory.setVirtualHost("/ming");

factory.setPort(5672);

Connection connection = factory.newConnection();

Channel channel = connection.createChannel();

channel.queueDeclare(

QUEUE_NAME,

false,

false,

false,

null

);

DeliverCallback deliverCallback = (consumerTag, delivery) -> {

String message = new String(delivery.getBody(), "UTF-8");

System.out.println(" [x] Received '" + message + "'");

};

channel.basicConsume(QUEUE_NAME, true, deliverCallback, consumerTag -> { });

}

}轮训

启动多个消费者,做到消费一个队列中的消息

一人接收一个

确定:消费者的能力不一样

// 处理完才接受下一条

int prefetchCount = 1;

channel.basicQos(prefetchCount);public static Connection getConnection() throws IOException, TimeoutException {

ConnectionFactory factory = new ConnectionFactory();

factory.setHost("101.227.11.219");

factory.setUsername("root");

factory.setPassword("mingyuefusu!");

factory.setVirtualHost("/ming");

factory.setPort(5672);

return factory.newConnection();

}recv

DeliverCallback deliverCallback = (consumerTag, delivery) -> {

try {

Thread.sleep(2000);

} catch (InterruptedException e) {

e.printStackTrace();

}

String message = new String(delivery.getBody(), "UTF-8");

System.out.println(" [x] Received '" + message + "'");

channel.basicAck(

delivery.getEnvelope().getDeliveryTag(),

false // false一条条确认消息

);

};

channel.basicConsume(

QUEUE_NAME,

true, // 手动确认收到消息

deliverCallback,

consumerTag -> { }

);发布订阅/广播 fanout

消息到达一个交换机后,会给绑定的所有队列都发送一样的消息

多个消费者收到同一条消息

send

try (

Connection connection = RabbitMqUtils.getConnection();

Channel channel = connection.createChannel();

) {

// 声明广播的交换机

channel.exchangeDeclare(EXCHANGE_NAME, BuiltinExchangeType.FANOUT);

String message = "Hello World!";

// 只需要放交换机即可

channel.basicPublish(

EXCHANGE_NAME,

"",

null,

message.getBytes(StandardCharsets.UTF_8)

);

System.out.println(" [x] Sent '" + message);

}recv

// 声明交换机

channel.exchangeDeclare(EXCHANGE_NAME, BuiltinExchangeType.FANOUT);

// 获取广播交换机中的队列

String queue = channel.queueDeclare().getQueue();

// 绑定队列和交换机

channel.queueBind(queue, EXCHANGE_NAME, "");

DeliverCallback deliverCallback = (consumerTag, delivery) -> {

String message = new String(delivery.getBody(), "UTF-8");

System.out.println(" [x] Received '" + message + "'");

};

channel.basicConsume(

queue,// 监听的还是队列

true, // 自动回复

deliverCallback,

consumerTag -> { }

);路由模式 direct

会员才能看到会员专属的信息

缺点:路由key太多难以管理

send

try (

Connection connection = RabbitMqUtils.getConnection();

Channel channel = connection.createChannel();

) {

channel.exchangeDeclare(EXCHANGE_NAME, "direct");

String[] argv = {"info", "error", "warn", "debug"};

for (String severity : argv) {

String message = "my " + severity;

// 交换机、路由、是否持久化、消息内容

channel.basicPublish(EXCHANGE_NAME, severity, null, message.getBytes("UTF-8"));

System.out.println(" [x] Sent '" + severity + "':'" + message + "'");

}

}recv

channel.exchangeDeclare(EXCHANGE_NAME, "direct");

String queueName = channel.queueDeclare().getQueue();

String[] argv = {"info", "error", "warn", "debug"};

for (String severity : argv) {

channel.queueBind(queueName, EXCHANGE_NAME, severity);

}

DeliverCallback deliverCallback = (consumerTag, delivery) -> {

String message = new String(delivery.getBody(), "UTF-8");

System.out.println(" [x] Received '" +

delivery.getEnvelope().getRoutingKey() + "':'" + message + "'");

};

channel.basicConsume(queueName, true, deliverCallback, consumerTag -> { });主题模式

*唯一单词,#0或多个

发送详细,接受通配

匹配不到默认丢弃

send

channel.exchangeDeclare(EXCHANGE_NAME, "topic");

String routingKey = getRouting(argv);

String message = getMessage(argv);

// 交换机 路由 持久化 内容

channel.basicPublish(EXCHANGE_NAME, routingKey, null, message.getBytes("UTF-8"));recv

channel.exchangeDeclare(EXCHANGE_NAME, "topic");

// 为什么能获取队列名?如果这个交换机有多个队列呢? 但是这里好像是先有的接收

String queueName = channel.queueDeclare().getQueue();

String[] argv = {"com.#"};

for (String bindingKey : argv) {

channel.queueBind(queueName, EXCHANGE_NAME, bindingKey);

}

DeliverCallback deliverCallback = (consumerTag, delivery) -> {

String message = new String(delivery.getBody(), "UTF-8");

System.out.println(" [x] Received '" +

delivery.getEnvelope().getRoutingKey() + "':'" + message + "'");

};

channel.basicConsume(queueName, true, deliverCallback, consumerTag -> {

});RPC

客户端和服务端同步

官网:https://www.rabbitmq.com/tutorials/tutorial-six-java.html

client请求携带reply_to(队列名)和correlation_id发送至队列

server消费队列后,使用reply_to将消息发送至队列,client根据correlation_id取出

confirm

生产者的消息不能知道消息是否到达了队列,可以使用事务

channel.txSelect();

channel.txRollback();- 普通confirm(同步)

每发送一条消息,调用waitForConfirms()方法,等待服务器端confirm,实际上是一种串行confirm

- 批量confirm(同步)

每发送一条消息后,waitForConfirmOrDie(),等待服务器端confirm

- 异步confirm

提供回调方法,服务端confirm一条或多条消息后,client端会回调这个方法

channel.confirmSelect();

channel.waitForConfirms(); // 普通confirm

waitForConfirmOrDie(); // 批量模式,只要有一条没确认就抛异常send

public class Send {

private static final String QUEUE_NAME = "async";

public static void main(String[] temp) throws Exception {

Connection connection = RabbitMqUtils.getConnection();

Channel channel = connection.createChannel();

try {

final SortedSet<Long> confirmSet = Collections.synchronizedSortedSet(new TreeSet<Long>());

// 开启确认模式

channel.confirmSelect();

// 声明队列

channel.queueDeclare(QUEUE_NAME, false, false, false, null);

channel.addConfirmListener(new ConfirmListener() {

@Override

public void handleAck(long deliveryTag, boolean multiple) throws IOException {

if( multiple ) {

System.out.println("multiple" + deliveryTag);

// 删除 deliveryTag 项标识id ?

confirmSet.headSet(deliveryTag + 1L).clear();

} else {

System.out.println("single" + deliveryTag);

confirmSet.headSet(deliveryTag).clear();

}

}

@Override

public void handleNack(long deliveryTag, boolean multiple) throws IOException {

if(multiple) {

System.out.println("failed-multiple->" +deliveryTag);

confirmSet.headSet(deliveryTag +1L).clear();

} else {

System.out.println("failed-single->" +deliveryTag);

confirmSet.remove(deliveryTag);

}

}

});

while(true) {

String message = "hello world";

Long seqNo = channel.getNextPublishSeqNo();

channel.basicPublish("", QUEUE_NAME, null, message.getBytes("utf-8"));

confirmSet.add(seqNo);

}

} catch (Exception e) {

e.printStackTrace();

} finally {

if(null != channel && channel.isOpen()) {

channel.close();

}

if(null != channel && connection.isOpen()) {

connection.close();

}

}

}

//..

}recv

public static void main(String[] argv) throws Exception {

Connection connection = RabbitMqUtils.getConnection();

Channel channel = connection.createChannel();

channel.queueDeclare(

QUEUE_NAME,

false,

false,

false,

null

);

System.out.println(" [*] Waiting for messages. To exit press CTRL+C");

DeliverCallback deliverCallback = (consumerTag, delivery) -> {

String message = new String(delivery.getBody(), "UTF-8");

System.out.println(" [x] Received '" + message + "'");

};

channel.basicConsume(

QUEUE_NAME,

true, // 自动回复

deliverCallback,

consumerTag -> { }

);

}SpringAMQP

依赖

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter</artifactId>

<version>2.1.7.RELEASE</version>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

<version>2.1.7.RELEASE</version>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<version>2.1.7.RELEASE</version>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-amqp</artifactId>

<version>2.1.7.RELEASE</version>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-amqp</artifactId>

</dependency>

</dependencies>配置

开启使用

@EnableRabbit配合文件

spring:

# 1 broker接受回调,队列错误回调,消费端接受回调

rabbitmq:

host: 101.200.169.229

port: 5672

username: guest

password: guest

virtual-host: /

publisher-confirm-type: correlated

publisher-returns: true

# 抵达队列,异步方式回调

template:

mandatory: true

listener:

simple:

acknowledge-mode: manual

# 2

rabbitmq:

host: 101.227.11.219

port: 5672

username: root

password:

virtual-host: /ming

server:

port: 8081@Autowired

AmqpAdmin amqpAdmin;序列化方式

import org.springframework.amqp.support.converter.Jackson2JsonMessageConverter;

import org.springframework.amqp.support.converter.MessageConverter;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

@Configuration

public class MyRabbitConfig {

// 序列化方式,传输Object

@Bean

public MessageConverter messageConverter() {

return new Jackson2JsonMessageConverter();

}

}简单API

@SpringBootTest

@Slf4j

public class Test {

@Autowired

private AmqpAdmin amqpAdmin;

@Autowired

private RabbitTemplate rabbitTemplate;

// 交换机、队列、绑定

@org.junit.jupiter.api.Test

public void test() {

// exchange: durable autoDelete

DirectExchange hello = new DirectExchange("hello-exchange", true, false);

amqpAdmin.declareExchange(hello);

log.info("{} finish", "hello");

// queue: durable exclusive autoDelete

Queue queue = new Queue("hello-queue", true, false, false);

amqpAdmin.declareQueue(queue);

// binding

/* String destination, 目的地

Binding.DestinationType destinationType, 类型: 交换机、队列

String exchange, 交换机

String routingKey, 路由键

@Nullable Map<String, Object> arguments

*/

Binding binding = new Binding("hello-queue", Binding.DestinationType.QUEUE, "hello-exchange", "hello.java", null);

amqpAdmin.declareBinding(binding);

// send Msg

String msg = "hello world!!!";

rabbitTemplate.convertAndSend("hello-exchange", "hello.java", msg);;

}

}发送

OrderEntity orderEntity = new OrderEntity();

orderEntity.setOrderSn(UUID.randomUUID().toString());

orderEntity.setModifyTime(new Date());

// 反馈可以统一放到configuration中

/*

public MyRabbitConfig(RabbitTemplate rabbitTemplate) {

this.rabbitTemplate = rabbitTemplate;

initTemplate();

}

*/

rabbitTemplate.setConfirmCallback((data, ack, cause) -> {

if(ack) {

System.out.println("发送成功");

} else {

System.out.println("发送失败");

}

});

rabbitTemplate.setReturnCallback((msg, respCode, respText, exchange, routeingKey) -> {

System.out.println("发送失败" +msg );

});

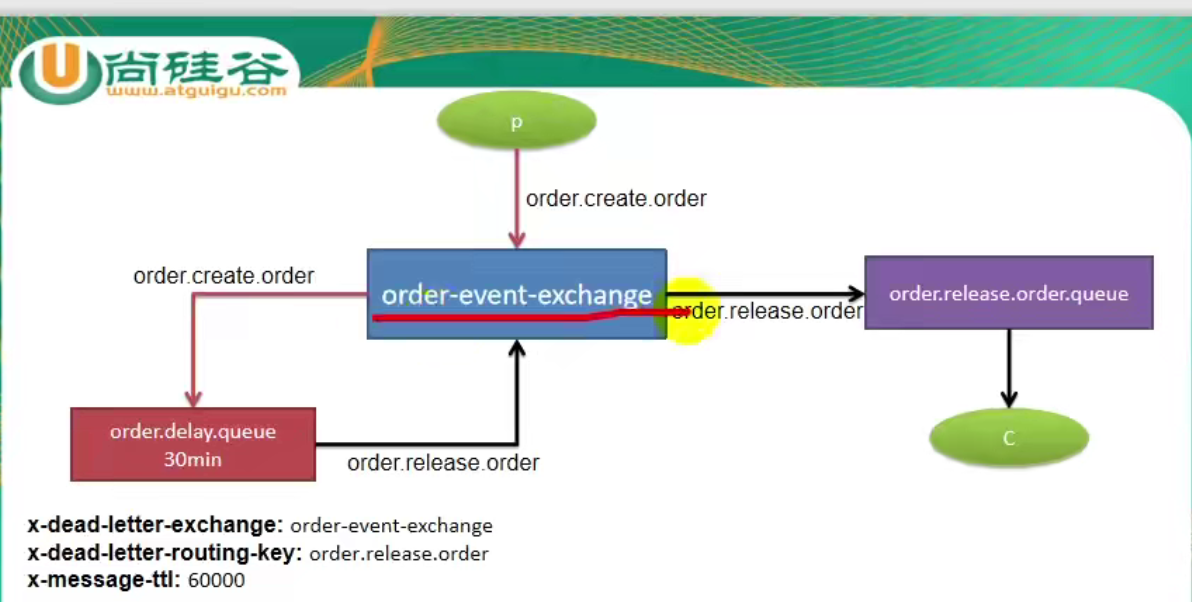

rabbitTemplate.convertAndSend("order-event-exchange", "order.create.order", orderEntity);Init资源

有listener才会创建

@Configuration

@EnableRabbit // 需要监听的时候要添加

public class RabbitMQConfig {

@Bean

public Exchange orderEventExchange() {

/**

* String name,

* boolean durable,

* boolean autoDelete,

* Map<String, Object> arguments

*/

return new TopicExchange("order-event-exchange", true, false);

}

@Bean

public Queue orderDelayQueue() {

HashMap<String, Object> paramMap = new HashMap<>();

paramMap.put("x-dead-letter-exchange", "order-event-exchange");

paramMap.put("x-dead-letter-routing-key", "order.release.order");

// 20s

paramMap.put("x-message-ttl", TimeUnit.SECONDS.toMillis(20L));

return new Queue("order.delay.queue", true, false, false, paramMap);

}

/**

* 普通队列

*

* @return

*/

@Bean

public Queue orderReleaseQueue() {

return new Queue("order.release.order.queue", true, false, false);

}

/**

* 创建订单的binding,order-event-exchange 和 order.delay.queue 通过路由 order.create.order绑定

* @return

*/

@Bean

public Binding orderCreateBinding() {

/**

* String destination, 目的地(队列名或者交换机名字)

* DestinationType destinationType, 目的地类型(Queue、Exhcange)

* String exchange,

* String routingKey,

* Map<String, Object> arguments

* */

return new Binding(

"order.delay.queue",

Binding.DestinationType.QUEUE,

"order-event-exchange",

"order.create.order",

null

);

}

}

样例2

@Configuration

public class DirectRabbitConfig {

@Bean

public Queue rabbitmqDemoDirectQueue() {

/**

* 1、name: 队列名称

* 2、durable: 是否持久化

* 3、exclusive: 是否独享、排外的。如果设置为true,定义为排他队列。则只有创建者可以使用此队列。也就是private私有的。

* 4、autoDelete: 是否自动删除。也就是临时队列。当最后一个消费者断开连接后,会自动删除。

* */

return new Queue(RabbitMQConfig.RABBITMQ_DEMO_TOPIC, true, false, false);

}

@Bean

public DirectExchange rabbitmqDemoDirectExchange() {

//Direct交换机

return new DirectExchange(RabbitMQConfig.RABBITMQ_DEMO_DIRECT_EXCHANGE, true, false);

}

@Bean

public Binding bindDirect() {

//链式写法,绑定交换机和队列,并设置匹配键

return BindingBuilder

//绑定队列

.bind(rabbitmqDemoDirectQueue())

//到交换机

.to(rabbitmqDemoDirectExchange())

//并设置匹配键

.with(RabbitMQConfig.RABBITMQ_DEMO_DIRECT_ROUTING);

}

}监听接收

如果已经创建好了队列,将不会覆盖,要删除队列

@Component

@RabbitListener(queues = {"order.release.order.queue"})

// 使用queuesToDeclare属性,如果不存在则会创建队列

// @RabbitListener(queuesToDeclare = @Queue(RabbitMQConfig.RABBITMQ_DEMO_TOPIC))

public class OrderCloseListener {

@RabbitHandler

public void getCloseOrderEntity(OrderEntity orderEntity, Channel channel, Message message) throws IOException {

System.out.println("接受到关闭订单" +orderEntity);

channel.basicAck(message.getMessageProperties().getDeliveryTag(), false);

}

}发送模式

from:https://developer.aliyun.com/article/769883#slide-13

直连、主题通过 routerKey 绑定交换机和队列

广播会发送到绑定了交换机的所有队列

header exchange 通过头部的信息和绑定的头部信息进行对比,相当于将路由键放在了头部

直连

@Configuration

public class DirectRabbitConfig {

@Bean

public Queue rabbitmqDemoDirectQueue() {

/**

* 1、name: 队列名称

* 2、durable: 是否持久化

* 3、exclusive: 排他队列,基于连接下,可以访问,不可重名,关闭连接就会删除

* 4、autoDelete: 是否自动删除。也就是临时队列。当最后一个消费者断开连接后,会自动删除。

* */

return new Queue(RabbitMQConfig.RABBITMQ_DEMO_TOPIC, true, false, false);

}

@Bean

public DirectExchange rabbitmqDemoDirectExchange() {

// Direct交换机

return new DirectExchange(RabbitMQConfig.RABBITMQ_DEMO_DIRECT_EXCHANGE, true, false);

}

@Bean

public Binding bindDirect() {

// 链式写法,绑定交换机和队列,并设置匹配键

return BindingBuilder

// 绑定队列

.bind(rabbitmqDemoDirectQueue())

// 到交换机

.to(rabbitmqDemoDirectExchange())

// 并设置匹配键

.with(RabbitMQConfig.RABBITMQ_DEMO_DIRECT_ROUTING);

}

}发送

rabbitTemplate.convertAndSend(

RabbitMQConfig.RABBITMQ_DEMO_DIRECT_EXCHANGE,

RabbitMQConfig.RABBITMQ_DEMO_DIRECT_ROUTING,

dataHashMap

);接收

@RabbitListener(

queuesToDeclare =

@Queue(RabbitMQConfig.RABBITMQ_DEMO_TOPIC)

)广播模式

通过将两个队列绑定到相同的交换机上,启动项目时就创建交换机和队列

不需要路由键

声明

@Component

public class DirectRabbitConfig implements BeanPostProcessor {

@Resource

private RabbitAdmin rabbitAdmin;

@Bean

public Queue fanoutExchangeQueueA() {

// 队列A

return new Queue(RabbitMQConfig.FANOUT_EXCHANGE_QUEUE_TOPIC_A, true, false, false);

}

@Bean

public Queue fanoutExchangeQueueB() {

// 队列B

return new Queue(RabbitMQConfig.FANOUT_EXCHANGE_QUEUE_TOPIC_B, true, false, false);

}

@Bean

public FanoutExchange rabbitmqDemoFanoutExchange() {

// 创建 FanoutExchange 类型交换机

return new FanoutExchange(

RabbitMQConfig.FANOUT_EXCHANGE_DEMO_NAME,

true,

false

);

}

@Bean

public Binding bindFanoutA() {

//队列A绑定到FanoutExchange交换机

return BindingBuilder

.bind(fanoutExchangeQueueA())

.to(rabbitmqDemoFanoutExchange());

}

@Bean

public Binding bindFanoutB() {

//队列B绑定到FanoutExchange交换机

return BindingBuilder.bind(fanoutExchangeQueueB()).to(rabbitmqDemoFanoutExchange());

}

@Override

public Object postProcessAfterInitialization(Object bean, String beanName) throws BeansException {

//启动项目即创建交换机和队列

rabbitAdmin.declareExchange(rabbitmqDemoFanoutExchange());

rabbitAdmin.declareQueue(fanoutExchangeQueueB());

rabbitAdmin.declareQueue(fanoutExchangeQueueA());

return null;

}

}发送

@Resource

private RabbitTemplate rabbitTemplate;

// 发布消息,就可以不指定路由

@Override

public String sendMsgByFanoutExchange(String msg) throws Exception {

Map<String, Object> message = getMessage(msg);

try {

rabbitTemplate.convertAndSend(RabbitMQConfig.FANOUT_EXCHANGE_DEMO_NAME, "", message);

return "ok";

} catch (Exception e) {

e.printStackTrace();

return "error";

}

}接受

@RabbitListener(

queuesToDeclare =

@Queue(RabbitMQConfig.FANOUT_EXCHANGE_QUEUE_TOPIC_A)

)

@RabbitHandler主题模式

通过”*” 、 “#”通配符,路由到对应的队列

* 符号:有且只匹配一个词

# 符号:匹配一个或多个词

一个带路由匹配规则的消息到来,交换机通过路由规则,发送到所有对应的队列

可以实现直连direct、广播fanout模式的,感觉主要是看路由键

header exchange

不是通过路由键,而是通过请求头中的键值

队列绑定时,能规定头部信息,x-match中的值为any/all,对消息的头部信息 和 队列绑定的头部信息进行匹配

@Component

public class RabbitConfig implements BeanPostProcessor {

@Bean

public Queue headersQueueA() {

return new Queue(RabbitMQConfig.HEADERS_EXCHANGE_QUEUE_A, true, false, false);

}

@Bean

public Binding bindHeadersA() {

Map<String, Object> map = new HashMap<>();

map.put("key_one", "java");

map.put("key_two", "rabbit");

// 全匹配

return BindingBuilder.bind(headersQueueA())

.to(rabbitmqDemoHeadersExchange())

.whereAll(map).match();

// 部分匹配

return BindingBuilder.bind(headersQueueB())

.to(rabbitmqDemoHeadersExchange())

.whereAny(map).match();

}

@Override

public Object postProcessAfterInitialization(Object bean, String beanName) throws BeansException {

rabbitAdmin.declareExchange(rabbitmqDemoHeadersExchange());

rabbitAdmin.declareQueue(headersQueueA());

rabbitAdmin.declareQueue(headersQueueB());

return null;

}

}发送

MessageProperties messageProperties = new MessageProperties();

// 消息持久化

messageProperties.setDeliveryMode(MessageDeliveryMode.PERSISTENT);

messageProperties.setContentType("UTF-8");

// 添加消息

messageProperties.getHeaders().putAll(headerDataMap);

Message message = new Message(msg.getBytes(), messageProperties);

rabbitTemplate.convertAndSend(

RabbitMQConfig.HEADERS_EXCHANGE_DEMO_NAME,

null,

message

);接受

@RabbitListener(queuesToDeclare = @Queue(RabbitMQConfig.HEADERS_EXCHANGE_QUEUE_B))

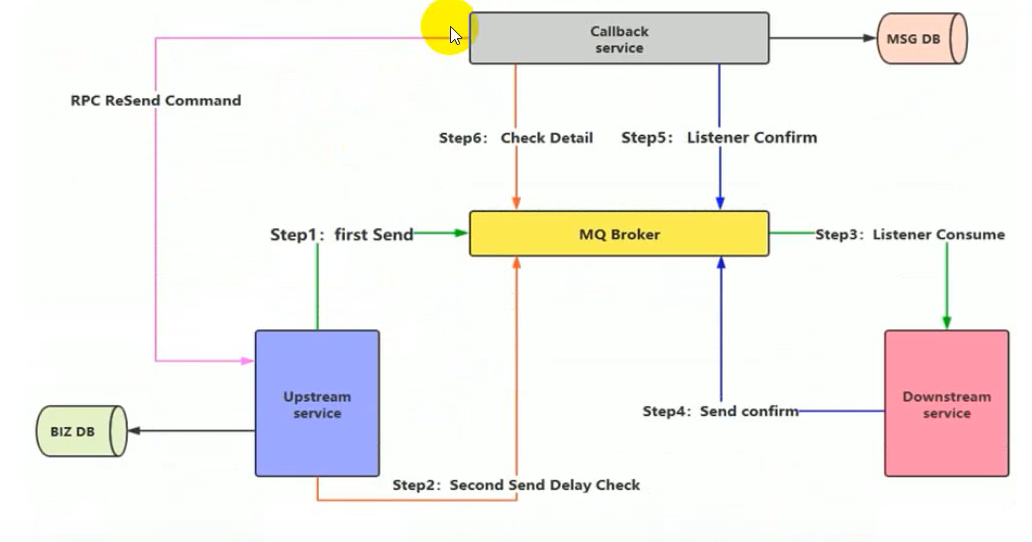

public void process(Message message) throws Exception {